Research on super-resolution reconstruction of mine images

-

摘要: 受井下粉尘大、照度低等环境影响,矿井图像存在分辨率低、细节模糊等问题,现有的图像超分辨率重建算法应用于矿井图像时,难以获取不同尺度图像信息、网络参数过大而影响重建速度,且重建图像易出现细节丢失、边缘轮廓模糊、伪影等问题。提出了一种基于多尺度密集通道注意力超分辨率生成对抗网络(SRGAN)的矿井图像超分辨率重建算法。设计了多尺度密集通道注意力残差块替代SRGAN原有的残差块,采用2路并行且卷积核大小不同的密集连接块,可充分获取图像特征;融入高效通道注意力模块,加强对高频信息的关注度;采用深度可分离卷积对网络进行轻量化,抑制网络参数的增加;利用纹理损失约束网络训练,避免网络加深时产生伪影。在井下数据集和公共数据集上对提出的矿井图像超分辨率重建算法和经典超分辨率重建算法BICUBIC,SRCNN,SRRESNET,SRGAN进行实验,结果表明:所提算法在主客观评价上总体优于对比算法,网络参数较SRGAN减少了2.54%,峰值信噪比与结构相似度较经典算法指标均值分别提高了0.764 dB和0.053 58,能更好地关注图像的纹理、轮廓等细节信息,重建图像更符合人眼视觉。

-

关键词:

- 矿井图像 /

- 超分辨率重建 /

- 超分辨率生成对抗网络 /

- 多尺度密集通道注意力残差块 /

- 高效通道注意力模块 /

- 深度可分离卷积 /

- 纹理损失

Abstract: Due to the impact of high dust and low illumination in underground environments, mine images have problems such as low resolution and blurry details. When existing image super-resolution reconstruction algorithms are applied to mine images, it is difficult to obtain image information at different scales. The network parameters are too large, which affects the reconstruction speed. The reconstructed images are prone to problems such as detail loss, blurry edge contours, and artifacts. A mine image super-resolution reconstruction algorithm based on multi-scale dense channel attention super-resolution generative adversarial network (SRGAN) is proposed. A multi-scale dense channel attention residual block is designed to replace the original residual block of SRGAN. Two parallel dense connected blocks with different convolutional kernel sizes are used to fully obtain image features. The efficient channel attention modules are integrated to enhance attention to high-frequency information. The depthwise separable convolution is used to lighten the network and suppress the increase of network parameters. The texture loss constraint network training is utilized to avoid artifacts during network deepening. Experiments are conducted on the proposed mine image super-resolution reconstruction algorithm and classic super-resolution reconstruction algorithms BICUBIC, SRCNN, SRRESNET, SRGAN on both underground and public datasets. The results show that the proposed algorithm outperformed the comparative algorithm in both subjective and objective evaluations. Compared to SRGAN, the proposed algorithm reduces network parameters by 2.54%. Compared to the average index values of the classic algorithms, the peak signal-to-noise ratio and structural similarity of the proposed algorithm increase by 0.764 dB and 0.053 58 respectively. It can better focus on the texture, contour and other details of the image, and the reconstructed image is more in line with human vision. -

0. 引言

矿井图像为井下安全监控、煤矸石运输、人员定位等提供重要参考依据。受井下特殊环境(粉尘大、照度低等)的影响及图像采集设备的限制,矿井图像往往分辨率低且细节模糊,阻碍信息表达[1-2]。因此,研究矿井图像超分辨率重建具有重要意义。

传统的图像超分辨率重建算法主要有基于插值的重建算法、基于重构的重建算法、基于传统学习的重建算法。基于插值的重建算法主要有最邻近插值法[3]、边缘导向插值法[4]、双线性插值法[5]、双三次线性插值法[6]等。该类算法操作简单,但重建效果有限。基于重构的重建算法包括非均匀内插法[7]、凸集投影法[8]、最大后验概率法[9]等。该类算法对先验信息的依赖性较强,且对边缘信息的提取能力不足。基于传统学习的重建算法包括样例学习法[10]、邻域嵌入法[11]、稀疏表示法[12-13]等。该类算法通过学习图像内部相关性来重建图像,但学习能力有限,不能很好地关注图像细节特征。

近年来,深度学习在图像处理领域得到广泛应用,许多学者尝试将深度学习用于图像超分辨率重建,取得了不错的效果。Dong Chao等[14]提出超分辨率卷积神经网络(Super-Resolution Convolutional Neural Network,SRCNN)算法,首次将图像超分辨率重建算法与深度学习相结合,利用卷积神经网络进行特征提取,极大地提高了重建图像质量。为解决SRCNN训练数据多、训练速度慢等问题,Dong Chao等[15]提出了快速超分辨率卷积神经网络(Fast Super-Resolution Convolutional Neural Network,FSRCNN),利用反卷积上采样层,在网络的最后进行上采样,直接将低分辨率图像作为输入,提高了网络训练速度。随着深度学习技术的发展,J. Kim等[16]提出了极深超分辨率卷积网络,利用残差结构构建更深的网络,提取更多的特征图,使重建后的图像拥有更丰富的细节纹理。但随着网络的不断加深,可能出现训练偏向一些不重要信息的情况。对此,Zhang Yulun等[17]将通道注意力机制与残差块相结合,抑制了低频信息的表达,使模型更专注于对重建有益的高频信息。程德强等[18]利用多尺度密集特征融合网络对图像进行特征提取,有效提取了丰富的图像特征,提高了图像重建质量。基于卷积神经网络的图像超分辨率重建算法重建的图像有较高的峰值信噪比(Peak Signal-to-Noise Ratio,PSNR),但通常缺乏高频细节信息,导致观感较差。C. Ledig 等[19]提出了超分辨率生成对抗网络(Super-Resolution Generative Adversarial Network,SRGAN)模型,采用跳跃连接的深度残差网络构成生成器,对低分辨率图像进行重建,利用判别器判断图像的真实性,采用感知损失代替原来的均方损失,使该模型重建的图像更加清晰自然。

虽然图像超分辨率重建技术得到了很好的发展,但在矿井图像重建上应用较少。程德强等[20]针对矿井图像边缘模糊不清的问题,对不同类型图像块训练不同的字典库,提出了多字典超分辨率图像重建算法。张剑英等[21]对非局部均值超分辨重建算法进行改进,通过对图像进行分区处理,实现了矿井视频图像的超分辨率重建。汪海涛等[22]利用在线字典学习优化多字典学习阶段的字典,提出了在线多字典学习的超分辨率重建方法,完成了矿井图像重建任务。程德强等[23]提出了基于卷积神经网络的矿井图像超分辨率重建算法,通过添加特征融合模块和坐标注意力机制来获取更多的高频信息,并构建了用于矿井图像超分辨率重建训练的数据集CUMID。上述方法针对矿井图像超分辨率重建问题取得了一定效果,但仍存在以下问题:① 矿井图像尺寸大小不一,单一尺度的特征提取不能很好地提取不同尺度的图像信息。② 矿井图像有大量的背景信息,纹理、轮廓等细节信息含量较少,部分网络忽略了中间层的信息交流,导致重建后的图像出现细节丢失、边缘轮廓模糊等问题。③ 随着网络的加深,会引入一些多余的结构,使得重建图像出现伪影,且会导致网络参数过大,影响模型的重建速度。

针对上述问题,本文提出一种基于多尺度密集通道注意力SRGAN的矿井图像超分辨率重建算法:构建了一种融合高效通道注意力(Efficient Channel Attention,ECA)机制[24]的多尺度密集通道注意力残差块(Multi−scale Dense Residual Channel Attention Block,MDRCAB)来代替SRGAN原有的残差块,利用纹理损失[25]代替感知损失对网络训练进行监督,采用深度可分离卷积(Depthwise Separable Convolution,DSC)[26]进行特征提取。采用矿井数据集对该算法进行测试,通过主客观评价验证了该算法对井下图像的重建效果优于经典图像超分辨率重建算法。

1. 多尺度密集通道注意力SRGAN

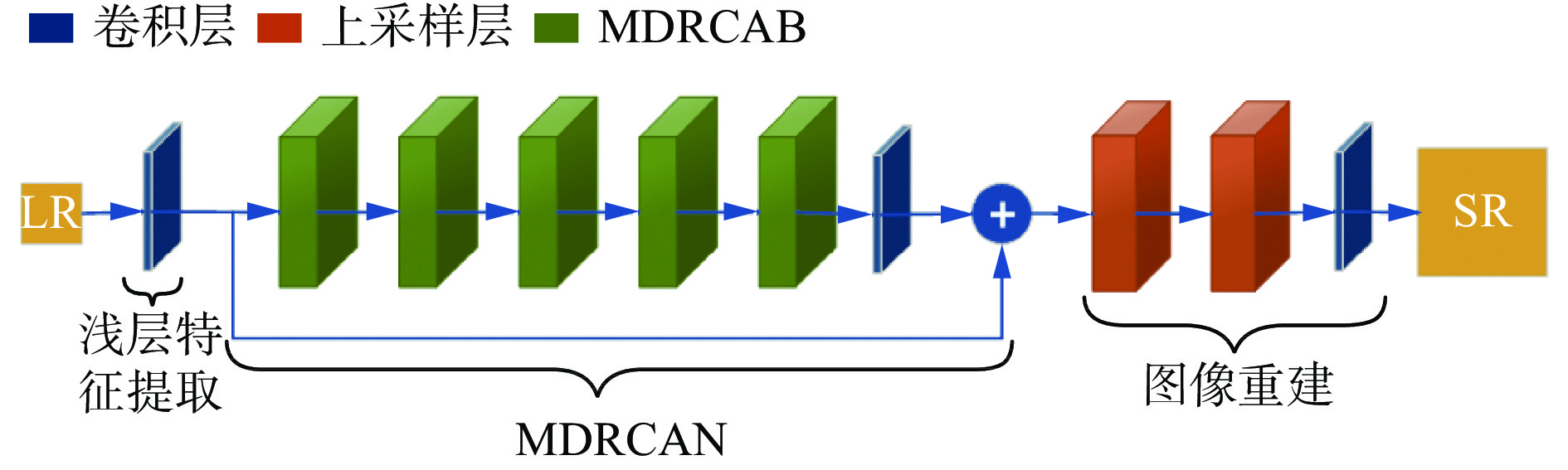

多尺度密集通道注意力SRGAN是在SRGAN基础上对生成器进行改进。改进的生成器由浅层特征提取模块、多尺度密集残差通道注意力网络(Multi−scale Dense Residual Channel Attention Net,MDRCAN)和图像重建模块3个部分组成,如图1所示。

1.1 浅层特征提取模块

采用1个卷积核尺寸为9×9、输出通道数为64的卷积层对低分辨率矿井图像进行初步特征提取,得到浅层特征图a0作为MDRCAN的输入。

$$ \boldsymbol{a}_0\text{ = }\boldsymbol{\delta}\left(\boldsymbol{F}_{9\times9}(\boldsymbol{I}_{\mathrm{LR}})\right) $$ (1) 式中:${\boldsymbol{\delta}} $为PReLU激活函数;F9×9为卷积层;ILR为输入图像。

1.2 MDRCAN

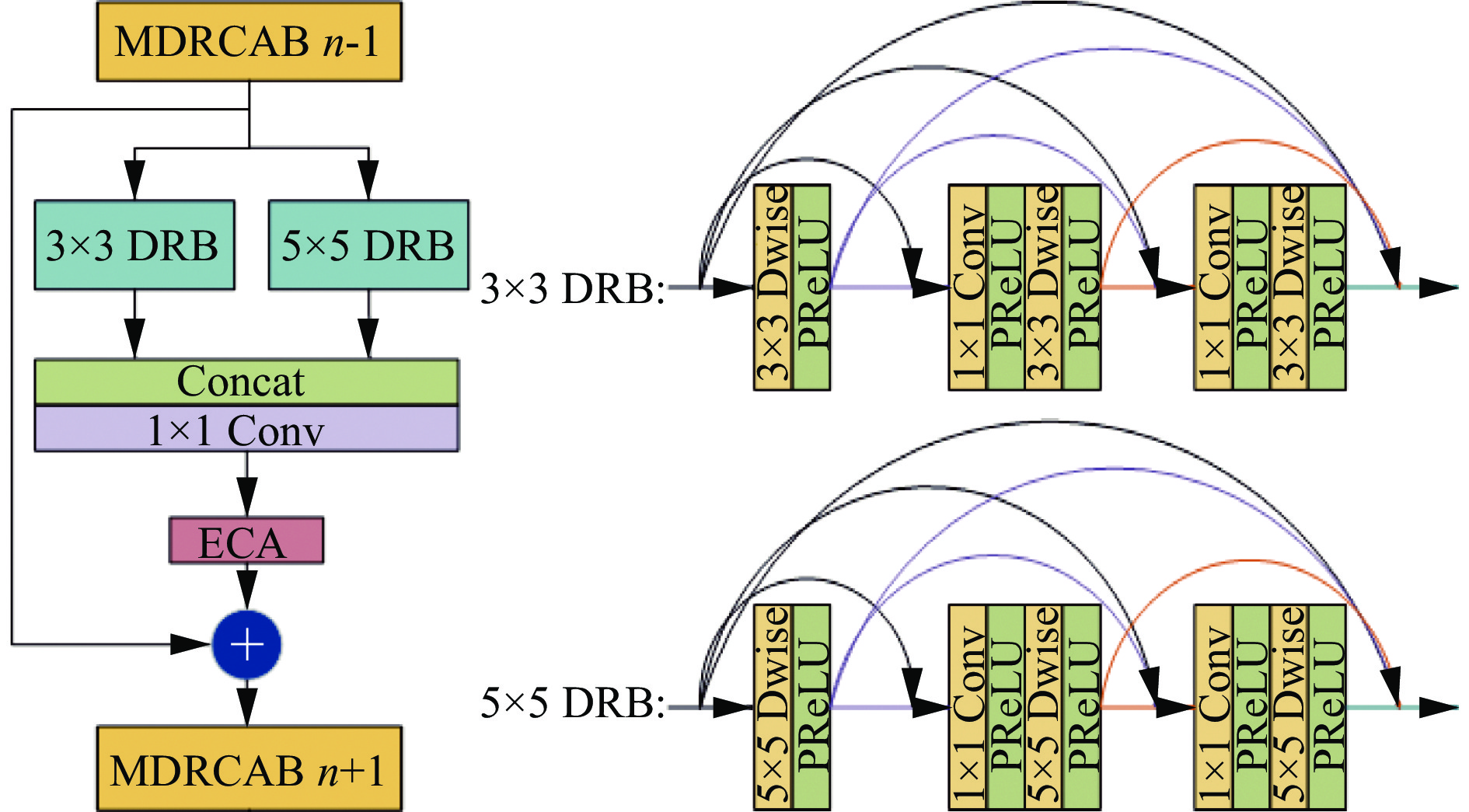

矿井图像含有大量低频信息,而反映图像结构的轮廓、纹理等高频信息较少,且矿井图像包含不同尺度的特征信息,普通的残差结构利用单一尺寸的卷积核对图像进行特征提取,难以捕捉到不同尺度的图像特征。另外,普通残差结构忽略了中间层的信息交流,不利于特征提取。针对上述问题,提出MDRCAN进行深层特征提取。MDRCAN由5个MDRCAB级联而成。MDRCAB结构如图2所示。其包含2路卷积核大小分别为3×3和5×5的密集残差块(Dense Residual Block,DRB),当有图像输入时,2路DRB分别进行特征提取,并在通道方向进行拼接,完成不同尺度的局部特征融合,实现了对矿井图像的多尺度特征提取。同时DRB加强了不同层的信息交流。以卷积核大小为3×3的DRB为例,其建立了前面层与后面所有层的连接关系,从全局角度挖掘深层次信息,实现特征在通道维度上的复用。在DRB中设置瓶颈结构,利用卷积核大小为1×1的卷积固定输出通道的大小,避免网络参数过大。在局部特征融合之后,采用ECA模块来提高富含高频信息特征图的权重,增强图像重建质量。第n(n=2,3,4,5)个MDRCAB的输出可表示为

$$ \boldsymbol{B}_n=\boldsymbol{E}(\boldsymbol{D}_3(\boldsymbol{B}_{n-1})*\boldsymbol{D}_5(\boldsymbol{B}_{n-1}))+\boldsymbol{B}_{n-1} $$ (2) 式中:E为ECA模块;D3,D5分别为3×3,5×5的DRB;$* $为拼接符号。

1.2.1 ECA模块

矿井图像的边缘纹理等高频信息较少,利用注意力机制提高对高频信息的关注度有利于矿井图像重建。目前,大多数注意力模块在提升性能的同时,会使模型变得更加复杂。ECA模块克服了性能和复杂性权衡的悖论,在只增加极少参数的同时带来极好的性能增益。ECA模块结构如图3所示。在不降维的通道全局平均池化聚合全局特征之后,将获得的特征向量输入卷积核大小为K的一维卷积中,对当前通道及邻近的K−1个通道的信息进行捕捉,实现局部跨通道交互。K决定了局部跨通道交互的范围,可以通过与通道维度C的映射关系自适应确定。

$$ K = {\left| {\frac{{{{\log }_2}C}}{\gamma } + \frac{b}{\gamma }} \right|_{{\mathrm{odd}}}} $$ (3) 式中:| t |odd为离t的最近奇数;γ,b分别为权重系数和偏置系数,按经验分别取2和1。

通过softmax操作获得每一个通道权重,将生成的通道权重和与之对应的特征图相乘,得到加权特征图。

1.2.2 DSC

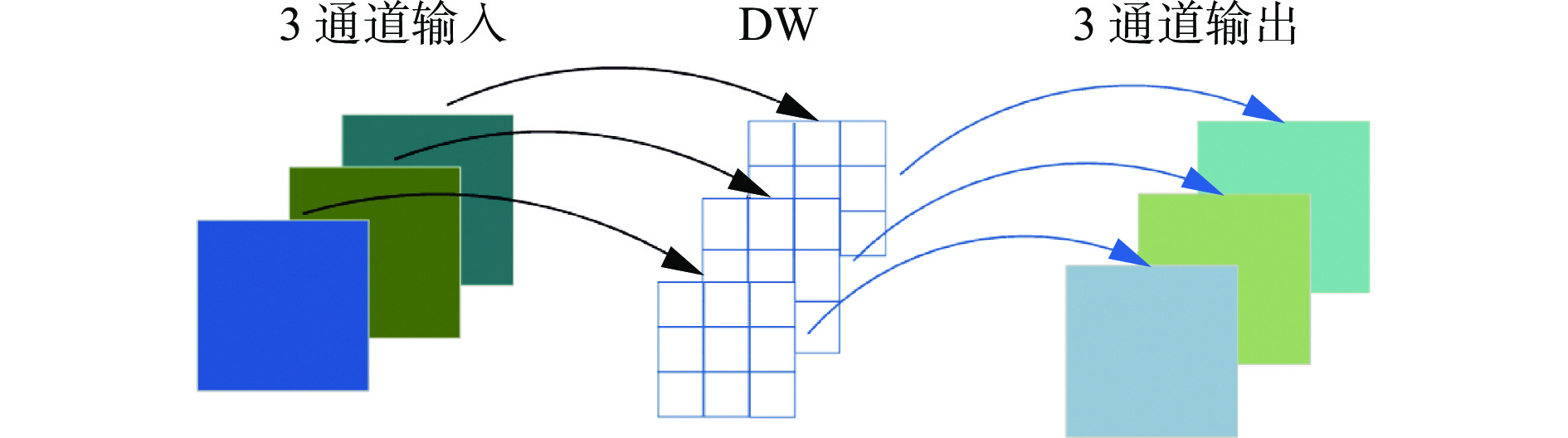

为降低网络参数,实现模型的轻量化,采用DSC对图像进行特征提取。DSC用2种不同的卷积分步提取图像特征。先由逐通道卷积(Depthwise Convolution,DW)对所有通道进行特征提取,过程如图4所示。

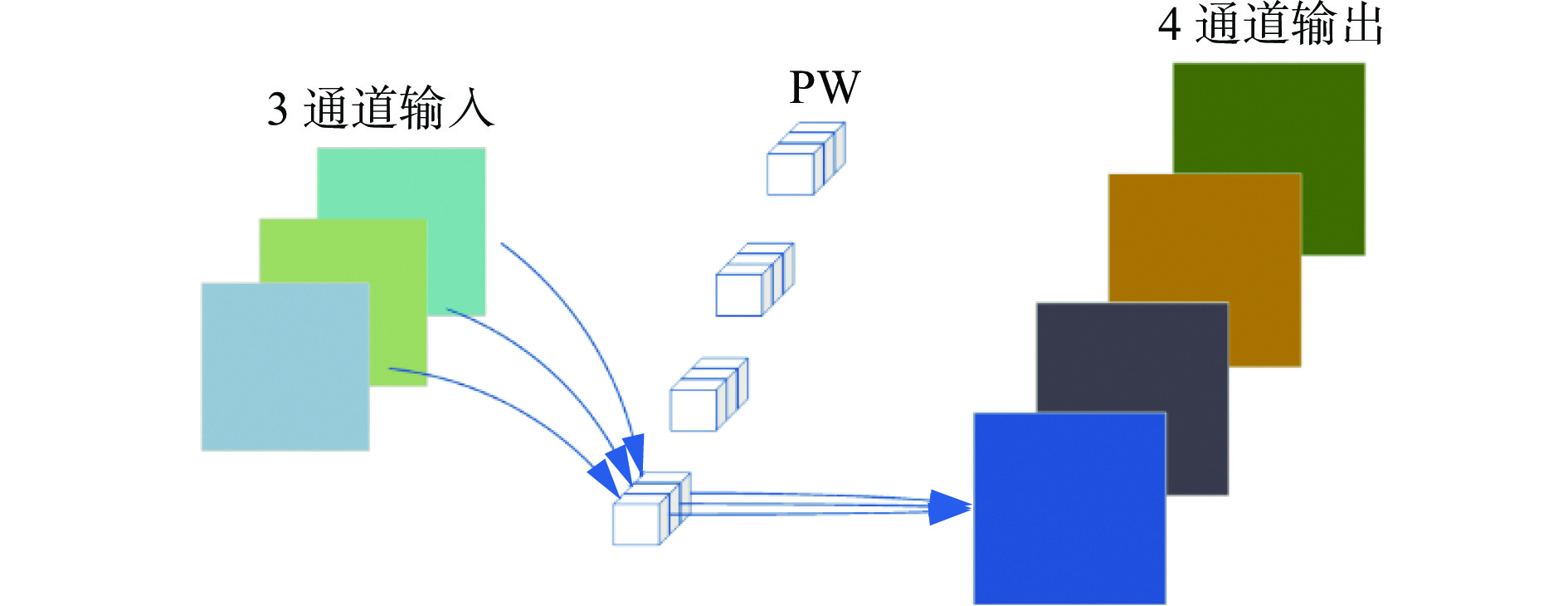

DW无法改变通道数,因此,还需进行逐点卷积(Pointwise Convolution, PW)操作,将提取的不同通道的信息交叉融合,得到新的特征图。PW过程如图5所示。

普通卷积的参数量为

$$ N = W H {C_{{\mathrm{in}}}} {C_{{\mathrm{out}}}} $$ (4) 式中:W,H分别为卷积核的宽和长;Cin为输入通道数;Cout为输出通道数。

DSC的参数量为

$$ N=C_{\mathrm{in}}WH+C_{\mathrm{in}}C_{\mathrm{out}} $$ (5) 假设Cin为4,Cout为5,卷积核尺寸为3×3,计算可得普通卷积的参数量为180,而DSC的参数量为56。可见,对于相同的输入图像,得到相同数量的特征图,DSC产生的参数量约为普通卷积的1/3。

1.3 图像重建模块

对矿井图像进行充分的特征提取后,采用亚像素卷积层对特征图进行上采样放大。放大后的图像为

$$ \boldsymbol{I}_{\mathrm{up}}=\boldsymbol{U}(\boldsymbol{B}_{\mathrm{\mathit{n}}}) $$ (6) 式中:U为亚像素上采样层;Bn为由MDRCAN提取的特征图。

将放大图像输入卷积核大小为9×9的卷积层F9×9,得到重建图像:

$$ \boldsymbol{I}_{\mathrm{SR}}=\boldsymbol{F}_{9\times9}(\boldsymbol{I}_{\mathrm{up}}) $$ (7) 1.4 损失函数

损失函数是影响矿井图像重建质量的关键因素之一。SRGAN采用内容损失和感知损失相结合的损失函数来优化网络参数,以实现对高频细节的关注。虽然感知损失可以提高图像重建效果,但会引入多余的高频信息,从而产生伪影。对此,采用纹理损失代替原来的感知损失,整体损失函数为

$$ {L_{{\mathrm{SR}}}} = L_{1_{{\mathrm{loss}}}}{\text{ + }}\alpha {L_{{\mathrm{tex}}}} $$ (8) 式中:$ L_{1_{{\mathrm{loss}}}} $为L1范数损失;α为权重系数,按经验取值为10−3;Ltex为纹理损失。

首先采用预训练网络分别提取重建图像和高分辨率图像的深层特征图,然后计算深层特征图的Gram矩阵, 最后利用L2损失函数比较深层特征的Gram矩阵,得到纹理损失。

$$ {L_{{\mathrm{tex}}}} = \left\| {{\boldsymbol{G}}({\boldsymbol{\phi }}({{\boldsymbol{I}}_{{\mathrm{gen}}}}) - {\boldsymbol{\phi}} ({{\boldsymbol{I}}_{{\mathrm{HR}}}}))} \right\|_2^2 $$ (9) 式中:Ltex为纹理损失;G 为 Gram 矩阵;${\boldsymbol{\phi}} $为预训练网络;Igen为重建图像;IHR为高清图像。

$$ \boldsymbol{G}\left(\boldsymbol{F}\right)=\boldsymbol{FF}^{\mathrm{T}} $$ (10) Gram矩阵可以捕捉图像的整体风格,有助于生成细节纹理。纹理损失的引入抑制了伪影的产生,使重建图像更符合人眼感官。

2. 实验与结果分析

2.1 实验环境及所用数据集

软硬件实验环境:处理器为AMD Ryzen 76800H;16 GiB系统内存;操作系统为Windows 10;显卡为NVIDIA RTX 3060,6 GiB显存容量;CUDA为11.7;深度学习框架为Pytorch1.13;编程语言为Python3. 9。

实验所用数据集为CUMID。其包含600张井下图像,根据图像编号顺序,每10张图像选取1张作为测试集,其余为训练集。为扩充训练样本,将训练集中图像随机旋转和水平翻转,最终将训练集扩充为1 620张。

2.2 客观评价指标

为对算法性能进行客观评价,采用PSNR[27]和结构相似度(Structural Similarity, SSIM)[28]对图像重建质量进行评估。

$$ R_{\mathrm{PSN}}=10\mathrm{lg}\frac{P_{\mathrm{max}}^2}{E_{\mathrm{MS}}} $$ (11) 式中:$R_{\mathrm{PSN}} $为重建图像PSNR;Pmax为像素点最大值;EMS为真实高分辨率图像与重建图像之间的均方误差。

PSNR越大,则像素之间的均方误差越小,重建图像质量越好。

SSIM主要从图像结构、对比度和亮度3个方面对图像质量进行评价,相较于PSNR更符合人眼的感官。

$$ S(x,y) = \frac{{(2{\mu _x}{\mu _y} + {c_1})(2{\sigma _{xy}} + {c_2})}}{{({\mu _x^2} + {\mu _y^2} + {c_1})({\sigma _x^2} + {\sigma _y^2} + {c_2})}} $$ (12) 式中:$S(x,y) $为重建图像SSIM;x,y分别为真实的高分辨率图像和重建的高分辨率图像;μx,μy 分别为x和y的平均灰度值;c1,c2均为常数;σxy为x和y的协方差;σx,σy分别为x,y的方差。

SSIM与图像质量呈正相关,SSIM越高,图像质量越好。

2.3 训练过程

训练过程中使用ADAM作为优化器,初始学习率设置为0.001。训练周期(epoch)为200,批训练数据量(batch_size)设为16。对生成对抗网络进行训练时,首先将提取的高分辨率图像(High-Resolution,HR)裁剪为像素为88×88的图像块,再将图像块进行4倍下采样,得到低分辨率图像(Low-Resolution,LR)块。将LR块输入生成器,得到一个假的HR块。将假HR块和真HR块输入判别器中进行打分,计算判别器的损失并将其反馈至生成器。生成器在获得判别器传来的对抗损失的同时,计算假HR块与真HR块之间的损失。生成器与判别器形成对抗,不断迭代优化,直至网络收敛。

2.4 实验结果与分析

2.4.1 客观评价结果分析

在相同的实验环境下,对本文算法与BICUBIC,SRCNN,SRRESNET,SRGAN等经典超分辨率重建算法进行4倍图像重建的训练与测试,并将各重建算法在测试集中的平均PSNR与SSIM进行对比,结果见表1。可看出本文算法与BICUBIC,SRCNN,SRRESNET,SRGAN相比,重建图像的平均PSNR分别提高了2.638,0.182,0.095,0.142 dB,平均SSIM分别提高了0.1947 3,0.004 97,0.005 85,0.008 77。PSNR的提高得益于MDRCAN的加入,在特征提取时保留了更完整的图像特征,使得重建后的图像与HR的像素值更加接近。SSIM的提高主要是由于ECA模块的加入,提高了网络对高频信息的关注度,使得重建后的图像在结构上与HR具有更高的相似度。

表 1 不同超分辨率重建算法的客观指标对比Table 1. The comparison of objective indexes of different super-resolution reconstruction algorithms算法 PSNR/dB SSIM BICUBIC 23.889 0.644 85 SRCNN 26.345 0.834 61 SRRESNET 26.432 0.833 73 SRGAN 26.385 0.830 81 本文算法 26.527 0.839 58 2.4.2 主观视觉分析

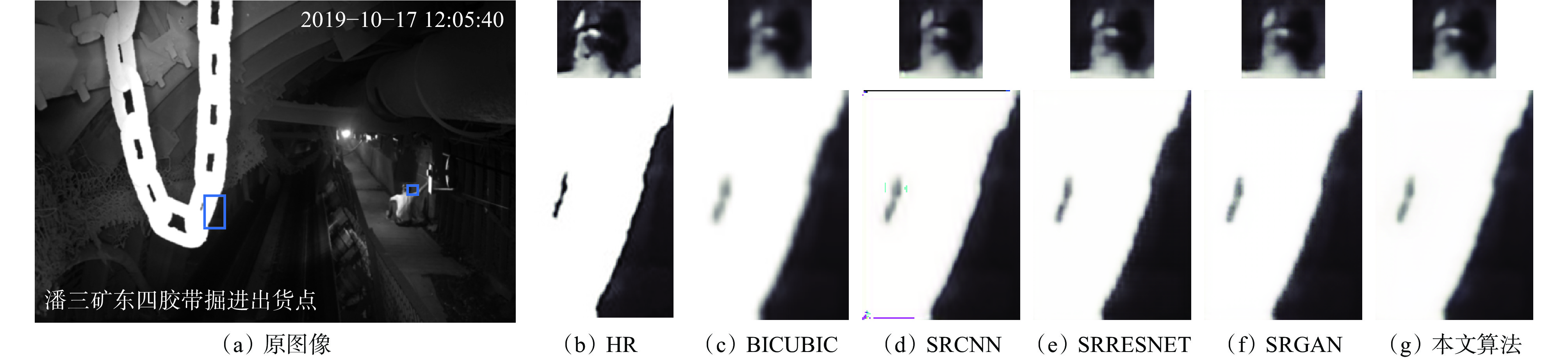

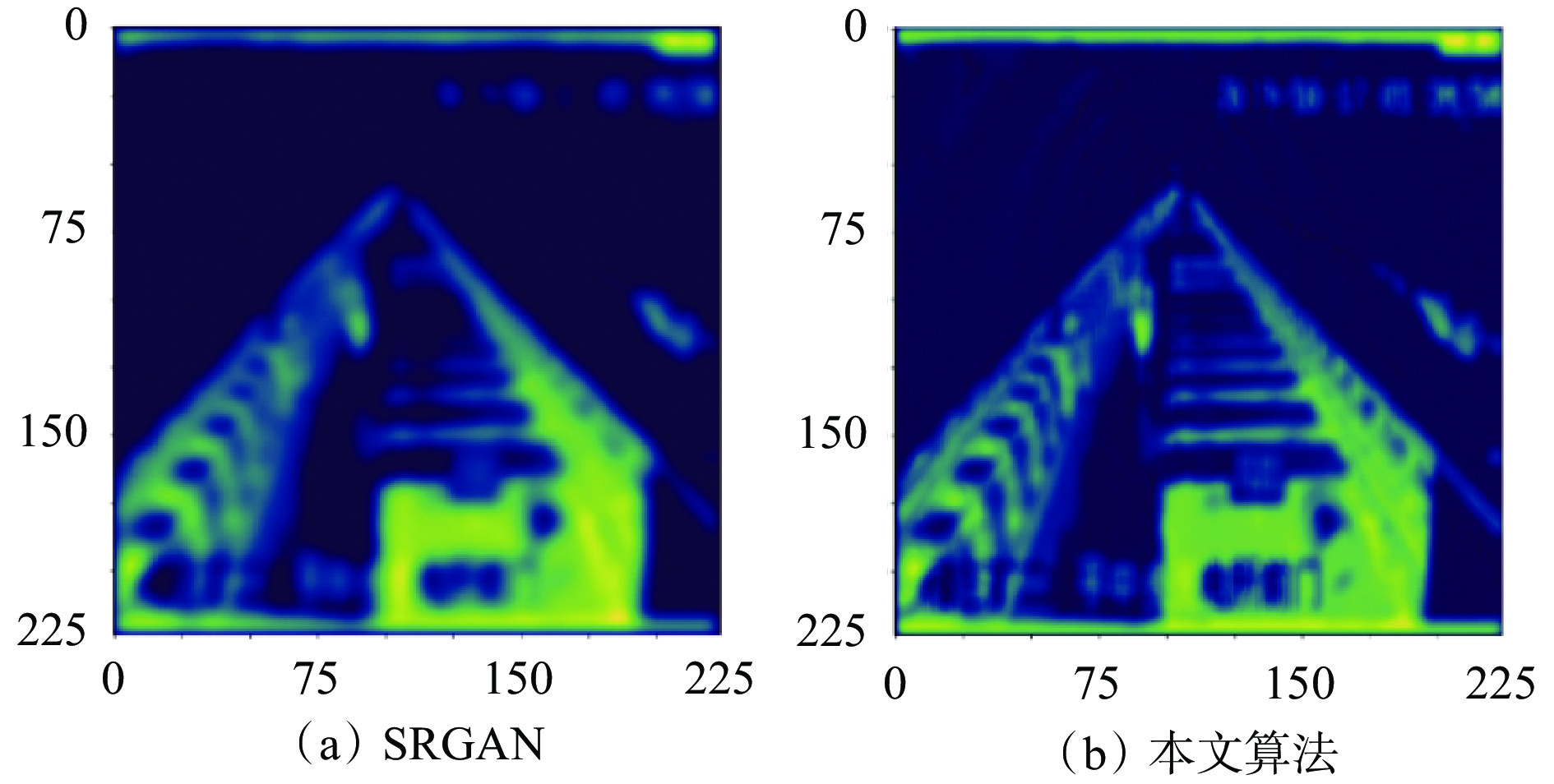

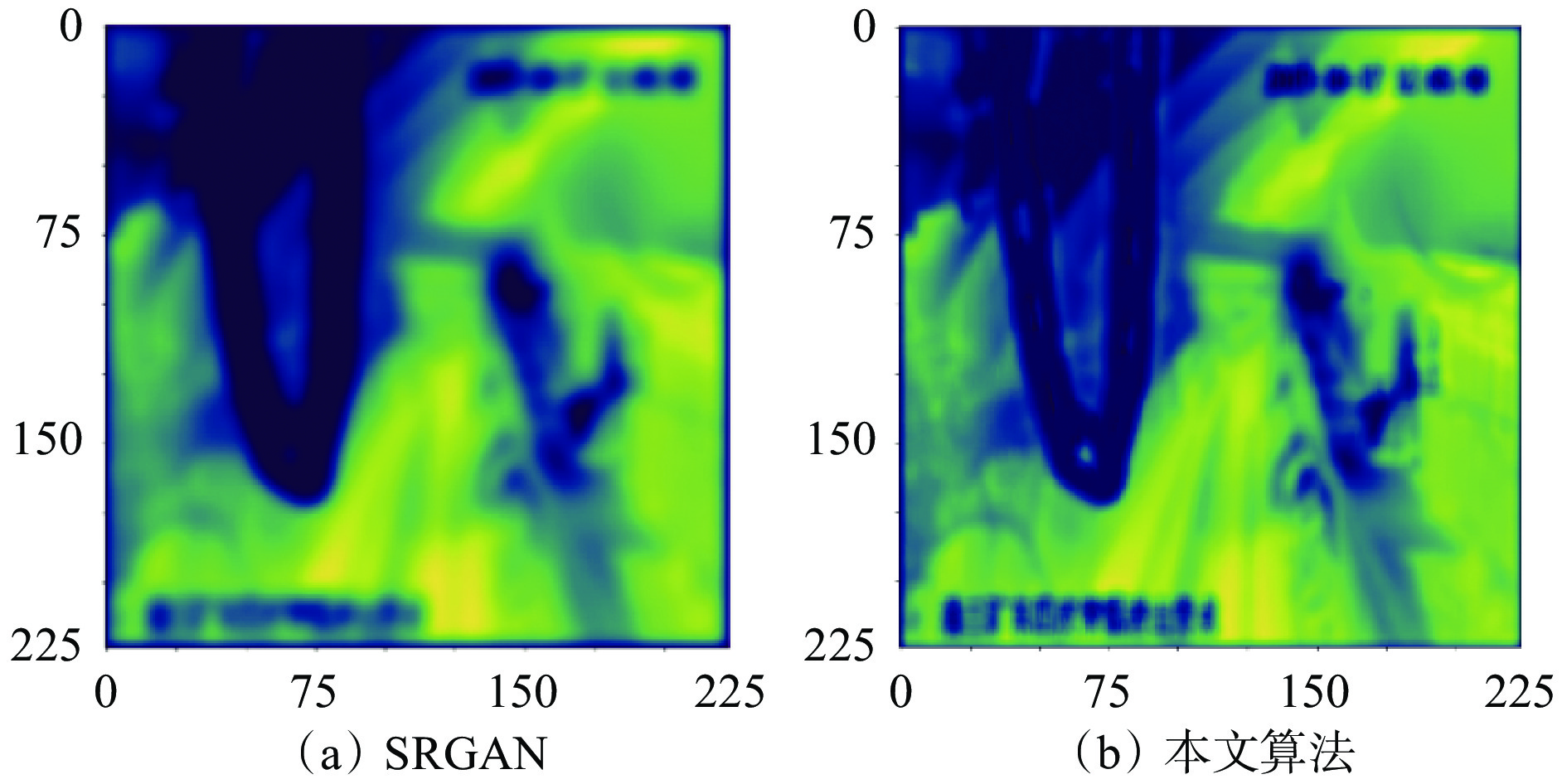

为更好地验证本文算法在井下图像重建方面的优越性,从人眼主观视觉的角度进行进一步验证。实验结果如图6和图7所示。对于场景1,本文算法重建图像中的“高压危险 严禁靠近”8个字较对比算法更接近原图,细节纹理更丰富。相较于SRGAN,本文算法利用纹理损失能更好地匹配局部纹理信息,抑制了伪影的产生,使得重建图像边缘更清晰。对于场景2,本文算法利用MDRCAN在灰暗模糊的图像中提取更多的细节纹理信息,相较于对比算法,更好地恢复了图像中工人头部的细节,同时铁链轮廓与HR更相似。

2.4.3 特征图可视化

为进一步验证本文算法在特征提取方面的优越性,将本文算法和SRGAN算法提取的特征图可视化并进行对比,如图8、图9所示。在场景1中,本文算法提取的细节纹理和轮廓等高频信息更加清晰,表明本文算法对高频信息有更高的关注度。在场景2中,本文算法对于灰暗模糊的图像能提取到更多的高频信息,边缘轮廓信息提取能力更强。

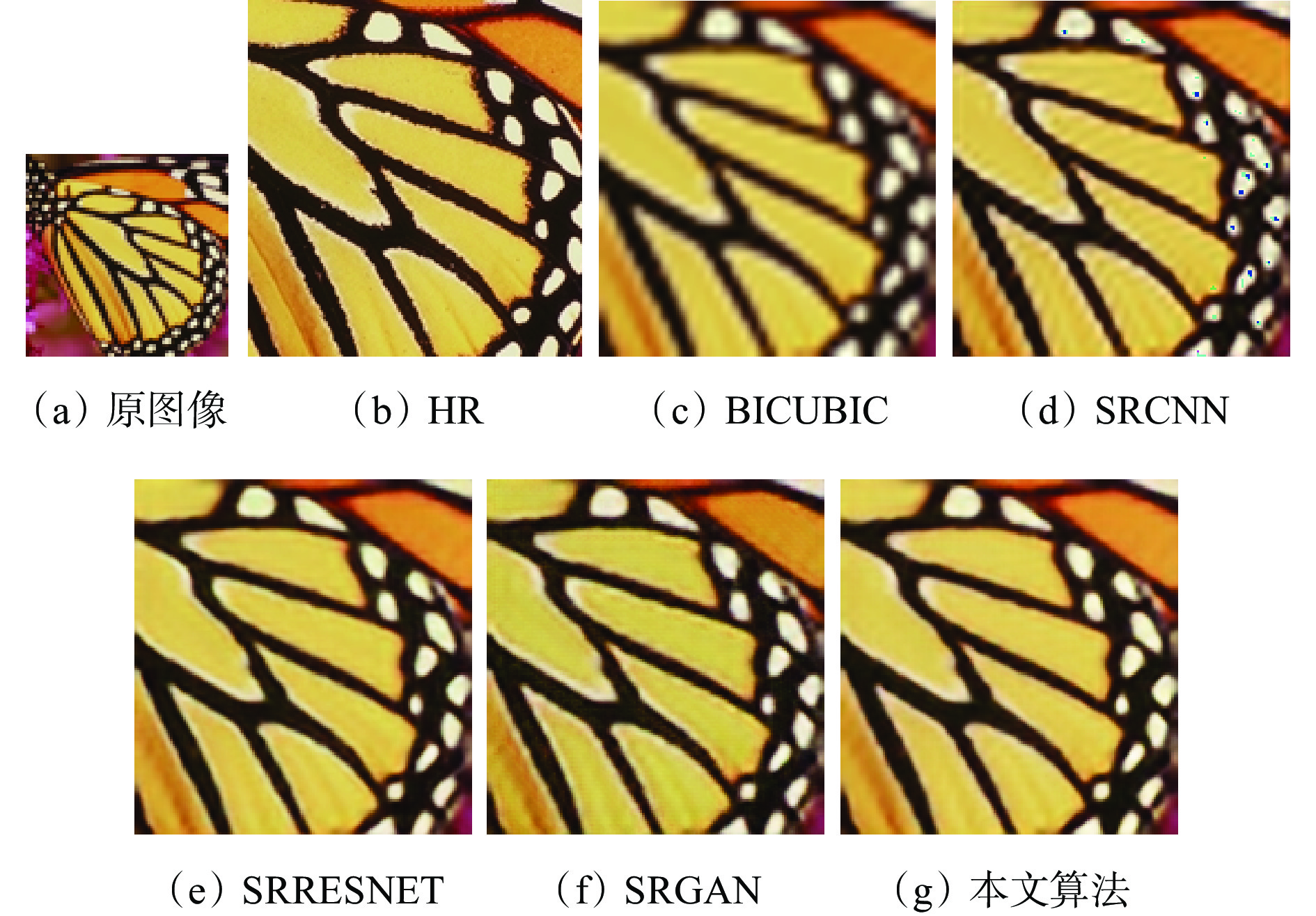

2.4.4 公共测试集上的对比

选取公共数据集DIV2K对模型进行训练,并分别在数据集Set5,Set14,BSD100,Urban100上进行对比,结果见表2。可看出本文算法在Set5,Set14,BSD100数据集上的PSNR与SSIM均取得了最优。对于Urban100数据集,本文算法指标仅略次于SRRESNET。各算法对基准数据集图像的重建效果对比如图10所示。可看出相较于对比算法,本文算法重建的图像拥有更清晰的纹理细节;相较于SRGAN,本文算法有效抑制了伪影的产生。可以得出,本文算法在公共数据集上具有明显的优越性。

表 2 各算法在公共数据集上的PSNR和 SSIM 对比(缩放因子为4)Table 2. The comparison of PSNR and SSIM of different super-resolution reconstruction algorithms in common data sets (scaling factor is 4)算法 Set5 Set14 BSD100 Urban100 PSNR/dB SSIM PSNR/dB SSIM PSNR/dB SSIM PSNR/dB SSIM BICUBIC 20.216 0.544 33 19.592 0.471 52 20.271 0.445 42 18.582 0.425 02 SRCNN 27.769 0.807 65 25.113 0.711 13 25.199 0.683 31 22.384 0.670 02 SRRESNET 28.071 0.830 06 25.385 0.727 89 25.481 0.694 45 23.011 0.701 56 SRGAN 27.983 0.818 03 25.369 0.719 52 25.337 0.689 02 22.857 0.693 85 本文算法 28.366 0.832 21 25.594 0.729 29 25.505 0.694 96 22.948 0.701 32 注:粗体为各列最优,下划线为各列次优。 2.5 消融实验

为了验证多尺度密集连接、ECA机制、DSC及纹理损失对算法性能及复杂度的影响,对这4个点进行消融实验。不同组合的模型PSNR和SSIM对比见表3。其中模型a表示原始SRGAN,模型b表示加入多尺度密集连接,模型c表示在模型b的基础上加上DSC,模型d表示在模型b上加入ECA机制,模型e表示同时加入多尺度密集连接、DSC和ECA机制,模型f表示在模型e的基础上使用纹理损失进行训练。

表 3 不同优化策略的消融实验结果对比Table 3. The comparison of ablation results of different optimization strategies模型 多尺度密

集连接DSC ECA 纹理

损失PSNR/dB SSIM 参数量/个 a 26.385 0.830 81 734 219 b √ 26.471 0.836 02 1 656 336 c √ √ 26.464 0.835 13 715 536 d √ √ 26.530 0.840 73 1 656 351 e √ √ √ 26.523 0.838 60 715 551 f √ √ √ √ 26.527 0.839 58 715 551 从表3可看出,加入多尺度密集连接的模型较原模型在PSNR和SSIM方面分别提升了0.086 dB和0.005 21,但参数量上升了55.6%,说明多尺度密集连接可以提高网络的重建性能,但会大幅度增加网络的复杂度;加入DSC后,模型c较模型b在PSNR和SSIM上有所下降,但参数量减少了56.8%,说明DSC可以极大地减少网络复杂程度,但伴随着一定的性能下降;加入ECA机制后,模型d较模型b在PSNR和SSIM方面分别提升了0.059 dB和0.004 71,参数量几乎不变,说明ECA机制在提升网络性能的同时,几乎不影响网络复杂程度;比较模型f和模型e可看出,使用纹理损失对网络进行优化时,PSNR的增长并不明显,但SSIM增加了0.000 98,说明纹理损失能使网络更加关注图像的结构特征;模型f较模型a参数量减少了2.54%,但PSNR和SSIM分别提高了0.142 dB与0.008 77,可见改进后的模型在性能提升的同时,有效抑制了网络参数的增加。

3. 结论

1) 针对矿井图像分辨率低、边缘细节模糊等问题,在生成对抗网络的基础上,提出了一种基于多尺度密集通道注意力SRGAN的矿井图像超分辨率重建算法。

2) 基于多尺度密集通道注意力SRGAN的矿井图像超分辨率重建算法利用不同尺寸的卷积核对矿井图像进行特征提取,解决了单一尺度的特征提取不能有效获取不同尺度图像信息的问题;将密集连接网络和残差结构结合,加强了网络内部层与层的信息交流,融入ECA机制提高了网络对高频信息的关注度,有效提升了矿井图像的重建效果;利用纹理损失对网络训练进行监督,有效避免了伪影的产生;利用DSC进行特征提取,有效抑制了网络参数的增加。

3) 在井下数据集上进行测试,提出的矿井图像超分辨率重建算法在主客观评价上均优于BICUBIC,SRCNN,SRRESNET,SRGAN等经典算法,有效恢复了矿井图像的高频细节信息,提高了图像重建质量。

-

表 1 不同超分辨率重建算法的客观指标对比

Table 1 The comparison of objective indexes of different super-resolution reconstruction algorithms

算法 PSNR/dB SSIM BICUBIC 23.889 0.644 85 SRCNN 26.345 0.834 61 SRRESNET 26.432 0.833 73 SRGAN 26.385 0.830 81 本文算法 26.527 0.839 58 表 2 各算法在公共数据集上的PSNR和 SSIM 对比(缩放因子为4)

Table 2 The comparison of PSNR and SSIM of different super-resolution reconstruction algorithms in common data sets (scaling factor is 4)

算法 Set5 Set14 BSD100 Urban100 PSNR/dB SSIM PSNR/dB SSIM PSNR/dB SSIM PSNR/dB SSIM BICUBIC 20.216 0.544 33 19.592 0.471 52 20.271 0.445 42 18.582 0.425 02 SRCNN 27.769 0.807 65 25.113 0.711 13 25.199 0.683 31 22.384 0.670 02 SRRESNET 28.071 0.830 06 25.385 0.727 89 25.481 0.694 45 23.011 0.701 56 SRGAN 27.983 0.818 03 25.369 0.719 52 25.337 0.689 02 22.857 0.693 85 本文算法 28.366 0.832 21 25.594 0.729 29 25.505 0.694 96 22.948 0.701 32 注:粗体为各列最优,下划线为各列次优。 表 3 不同优化策略的消融实验结果对比

Table 3 The comparison of ablation results of different optimization strategies

模型 多尺度密

集连接DSC ECA 纹理

损失PSNR/dB SSIM 参数量/个 a 26.385 0.830 81 734 219 b √ 26.471 0.836 02 1 656 336 c √ √ 26.464 0.835 13 715 536 d √ √ 26.530 0.840 73 1 656 351 e √ √ √ 26.523 0.838 60 715 551 f √ √ √ √ 26.527 0.839 58 715 551 -

[1] CHENG Deqiang,CHEN Liangliang,LYU Chen,et al. Light-guided and cross-fusion U-Net for anti-illumination image super-resolution[J]. IEEE Transactions on Circuits and Systems for Video Technology,2022,32(12):8436-8449. DOI: 10.1109/TCSVT.2022.3194169

[2] CHEN Liangliang,GUO Lin,CHENG Deqiang,et al. Structure-preserving and color-restoring up-sampling for single low-light image[J]. IEEE Transactions on Circuits and Systems for Video Technology,2022,32(4):1889-1902. DOI: 10.1109/TCSVT.2021.3086598

[3] JIANG Nan,WANG Luo. Quantum image scaling using nearest neighbor interpolation[J]. Quantum Information Processing,2015,14(5):1559-1571. DOI: 10.1007/s11128-014-0841-8

[4] LI Xin,ORCHARD M T. New edge-directed interpolation[J]. IEEE Transactions on Image Processing,2001,10(10):1521-1527. DOI: 10.1109/83.951537

[5] 程相正,曾朝阳,陈杭,等. 基于双线性插值算法的低分辨率传感器标定方法[J]. 激光与光电子学进展,2013,50(7):72-78. CHENG Xiangzheng,ZENG Zhaoyang,CHEN Hang,et al. Calibration method of low-resolution sensor based on bilinear interpolation strategy[J]. Laser & Optoelectronics Progress,2013,50(7):72-78.

[6] ZHU Yubin,DAI Yonghang,HAN Kaining,et al. An efficient BICUBIC interpolation implementation for real-time image processing using hybrid computing[J]. Journal of Real-Time Image Processing,2022,19(6):1211-1223. DOI: 10.1007/s11554-022-01254-8

[7] NASONOV A V,KRYLOV A. Fast super-resolution using weighted median filtering[C]. 20th International Conference on Pattern Recognition,Istanbul,2010:2230-2233.

[8] HUANG Jin,GAO Bo,CHEN Yan,et al. Super-resolution reconstruction of multi-polarization sar images based on projections onto convex sets algorithm[C]. IEEE International Geoscience and Remote Sensing Symposium,Valencia,2018:8456-8459.

[9] 郭黎,廖宇,陈为龙,等. 基于最大后验概率的单视频时间超分辨率重建算法[J]. 计算机应用,2014,34(12):3580-3584. GUO Li,LIAO Yu,CHEN Weilong,et al. Single video temporal super-resolution reconstruction algorithm based on maximum a posterior[J]. Journal of Computer Applications,2014,34(12):3580-3584.

[10] FREEMAN W T,JONES T R,PASZTOR E C. Example based super-resolution[J]. IEEE Computer Graphics and Applications,2002,22(2):56-65. DOI: 10.1109/38.988747

[11] GLASNER D,BAGON S,IRANI M. Super-resolution from a single image[C]. IEEE 12th International Conference on Computer Vision,Kyoto,2009:349-356.

[12] 梁美彦,张宇,梁建安,等. 基于稀疏编码非局部注意力对偶网络的病理图像超分辨率重建[J]. 计算机科学,2023,50(增刊1):305-312. LIANG Meiyan,ZHANG Yu,LIANG Jian'an,et al. Pathological image super-resolution reconstruction based on sparse coding non-local attention dual network[J]. Computer Science,2023,50(S1):305-312.

[13] 杨雪,李峰,鹿明,等. 混合稀疏表示模型的超分辨率重建[J]. 遥感学报,2022,26(8):1685-1697. DOI: 10.11834/jrs.20219409 YANG Xue,LI Feng,LU Ming,et al. New super-resolution reconstruction method based on mixed sparse representations[J]. National Remote Sensing Bulletin,2022,26(8):1685-1697. DOI: 10.11834/jrs.20219409

[14] DONG Chao,LOY C C,HE Kaiming,et al. Learning a deep convolutional network for image super- resolution[C]. 13th European Conference on Computer Vision,Zurich,2014:184-199.

[15] DONG Chao,LOY C C,TANG Xiaoou,et al. Accelerating the super-resolution convolutional neural network[C]. 14th European Conference on Computer Vision,Amsterdam,2016:391-407.

[16] KIM J,LEE J K,LEE K M. Accurate image super-resolution using very deep convolutional networks[C]. IEEE Conference on Computer Visio and Pattern Recognition,Las Vegas,2016:1646-1654.

[17] ZHANG Yulun,LI Kunpeng,LI Kai,et al. Image super-resolution using very deep residual channel attention networks[C]. 15th European Conference on Computer Vision,Munich,2018:294-310.

[18] 程德强,赵佳敏,寇旗旗,等. 多尺度密集特征融合的图像超分辨率重建[J]. 光学精密工程,2022,30(20):2489-2500. DOI: 10.37188/OPE.20223020.2489 CHENG Deqiang,ZHAO Jiamin,KOU Qiqi,et al. Multi-scale dense feature fusion network for image super-resolution[J]. Optics and Precision Engineering,2022,30(20):2489-2500. DOI: 10.37188/OPE.20223020.2489

[19] LEDIG C,THEIS L,HUSZAR F,et al. Photo-realistic single image super-resolution using a generative adversarial network[C]. IEEE Conference on Computer Vision and Pattern Recognition,Honolulu,2017:105-114.

[20] 程德强,陈亮亮,蔡迎春,等. 边缘融合的多字典超分辨率图像重建算法[J]. 煤炭学报,2018,43(7):2084-2090. CHENG Deqiang,CHEN Liangliang,CAI Yingchun,et al. Image super-resolution reconstruction based on multi-dictionary and edge fusion[J]. Journal of China Coal Society,2018,43(7):2084-2090.

[21] 张剑英,宋玉龙,蔡迎春,等. 改进的非局部均值视频超分辨率重建算法[J]. 工矿自动化,2018,44(9):37-44. ZHANG Jianying,SONG Yulong,CAI Yingchun,et al. Improved super-resolution reconstruction algorithm of non-local mean video[J]. Industry and Mine Automation,2018,44(9):37-44.

[22] 汪海涛,于文洁,张光磊. 基于在线多字典学习的矿井图像超分辨率重建方法[J]. 工矿自动化,2020,46(9):74-78. WANG Haitao,YU Wenjie,ZHANG Guanglei. Super-resolution reconstruction method of mine image based on online multi-dictionary learning[J]. Industry and Mine Automation,2020,46(9):74-78.

[23] 程德强,陈杰,寇旗旗,等. 融合层次特征和注意力机制的轻量化矿井图像超分辨率重建方法[J]. 仪器仪表学报,2022,43(8):73-84. CHENG Deqiang,CHEN Jie,KOU Qiqi,et al. Lightweight super-resolution reconstruction method based on hierarchical features fusion and attention mechanism for mine image[J]. Chinese Journal of Scientific Instrument,2022,43(8):73-84.

[24] WANG Qilong,WU Banggu,ZHU Pengfei,et al. ECA-Net:efficient channel attention for deep convolutional neural networks [C]. IEEE/CVF Conference on Computer Vision and Pattern Recognition,Seattle,2020:11531-11539.

[25] 姜玉宁,李劲华,赵俊莉. 基于生成式对抗网络的图像超分辨率重建算法[J]. 计算机工程,2021,47(3):249-255. JIANG Yuning,LI Jinhua,ZHAO Junli. Image super-resolution reconstruction algorithm based on generative adversarial networks[J]. Computer Engineering,2021,47(3):249-255.

[26] 张磊,王浩盛,雷伟强,等. 基于YOLOv5s−SDE的带式输送机煤矸目标检测[J]. 工矿自动化,2023,49(4):106-112. ZHANG Lei,WANG Haosheng,LEI Weiqiang,et al. Coal gangue target detection of belt conveyor based on YOLOv5s-SDE[J]. Journal of Mine Automation,2023,49(4):106-112.

[27] HORÉ A,ZIOU D. Image quality metrics:PSNR vs SSIM[C]. International Conference on Pattern Recognition,Istanbul,2010:2366-2369.

[28] WANG Zhou,BOVIK A C,SHEIKH H R,et al. Image quality assessment:from error visibility to structural similarity[J]. IEEE Transactions on Image Processing,2004,13(4):600-612. DOI: 10.1109/TIP.2003.819861

-

期刊类型引用(1)

1. 梅秀庄,王星覃,徐刚,王颖. 基于改进YOLOv8的输送带表面破损检测. 煤矿机械. 2025(04): 189-191 .  百度学术

百度学术

其他类型引用(3)

下载:

下载: