Visible and infrared image fusion algorithm for underground personnel detection

-

摘要: 矿用智能车辆的工作环境光照条件复杂,在进行井下行人检测时可以通过融合可见光和红外图像,将红外线反射信息和细节纹理信息融合于可见光图像中,改善目标检测效果。传统的可见光和红外图像融合方法随着分解层数增多,会导致图像边缘和纹理模糊,同时融合时间也会增加。目前基于深度学习的可见光和红外图像融合方法难以平衡可见光和红外图像中的特征,导致融合图像中细节信息模糊。针对上述问题,提出了一种基于多注意力机制的可见光和红外图像融合算法(IFAM)。首先采用卷积神经网络对可见光和红外图像提取图像特征;然后通过空间注意力和通道注意力模块分别对提取出来的特征进行交叉融合,同时利用特征中梯度信息计算2个注意力模块输出特征的融合权值,根据权值融合2个注意力模块的输出特征;最后通过反卷积变换对图像特征进行还原,得到最终的融合图像。在RoadScene数据集和TNO数据集上的融合结果表明,经IFAM融合后的图像中同时具备了可见光图像中的背景纹理和红外图像中的行人轮廓特征信息;在井下数据集上的融合结果表明,在弱光环境下,红外图像可以弥补可见光的缺点,并且不受环境中其他光源的影响,在弱光条件下融合后的图像中行人轮廓依旧明显。对比分析结果表明,经IFAM融合后图像的信息熵(EN)、标准方差(SD)、梯度融合度量指标(QAB/F)、融合视觉信息保真度(VIFF)和联合结构相似性度量(SSIMu)分别为4.901 3,88.521 4,0.169 3,1.413 5,0.806 2,整体性能优于同类的LLF−IOI,NDM等算法。Abstract: The working environment and lighting conditions of mining intelligent vehicles are complex. When detecting underground personnel, infrared reflection information and detailed texture information can be fused into visible light images by fusing visible and infrared images to improve the target detection effect. Traditional visible and infrared image fusion methods can lead to blurring of image edges and textures as the number of decomposition layers increases, and the fusion time also increases. At present, deep learning based fusion methods for visible and infrared images are difficult to balance the features in visible and infrared images, resulting in blurred detail information in the fused images. In order to solve the above problems, the image fusion algorithm based on multiple attention modules (IFAM) is proposed. Firstly, convolutional neural networks are used to extract image features from visible and infrared images. Secondly, the extracted features are cross fused using spatial attention and channel attention modules. The fusion weights of the output features of the two attention modules are calculated using the gradient information in the features. The output features of the two attention modules are fused based on the weights. Finally, the image features are restored through deconvolution transformation to obtain the final fused image. The fusion results on the RoadScene dataset and TNO dataset indicate that the IFAM fused image contains both background texture information from visible light images and personnel contour feature information from infrared images. The fusion results on the underground dataset indicate that in low lighting environments, infrared images can compensate for the shortcomings of visible light and are not affected by other light sources in the environment. In low lighting conditions, the personnel contour in the fused image is still obvious. The comparative analysis results show that the information entropy (EN), standard deviation (SD), gradient fusion metric (QAB/F), visual information fidelity for fusion (VIFF), and the union structural similarity index measure (SSIMu) of the image after IFAM fusion are 4.901 3, 88.521 4, 0.169 3, 1.413 5, and 0.806 2, respectively. The overall performance is superior to similar algorithms such as LLF-IOI and NDM.

-

0. 引言

目前,我国煤矿多采用人工驾驶运输车辆。鉴于井下巷道环境复杂,作业人员繁多,驾驶员在疲劳驾驶或者误操作的情况下,容易造成车辆碰撞和侧翻等运输事故,威胁井下作业人员生命安全,影响生产效率。现阶段,我国煤矿开采技术正处于由传统开采转向智能化开采的关键时期。矿用运输车辆无人化作为智慧矿山建设的重要一环,很大程度上决定了煤矿开采的智能化程度[1]。矿用无人驾驶车辆的工作环境光照条件复杂,导致行人检测易出现漏检和误检现象,降低了矿用无人驾驶车辆的可靠性。

由于井下光照条件复杂,难以利用可见光对环境中的行人轮廓成像,在逆光和弱光情况下,需要联合其他图像传感器对环境中的行人目标成像,获取更多行人特征信息。红外摄像头通过补充红外线对场景成像,可以在复杂光照或弱光条件下工作,采集的图像为灰度图像。可见光摄像头可以提供场景中的细节纹理,具有更高的分辨率,且可见光图像更加契合人类的视觉系统。因此,可以通过融合红外和可见光图像,将红外线反射信息和细节纹理信息融合于可见光图像中,解决单个传感器的不足,改善目标检测效果。

红外与可见光图像融合方法主要分为传统方法和基于深度学习的方法[2]。传统方法中,多尺度变换融合方法[3]是目前该领域研究最广泛、应用最多的方法。基于多尺度变换的图像融合方法主要通过一组变换和逆变换模型来融合图像,典型的方法包括金字塔变换、小波变换[4]、非下采样轮廓波变换(Non-Subsampled Contourlet Transform,NSCT)[5-9]和边缘保持滤波器等[10]。多尺度变换融合方法随着分解层数增多,会导致图像边缘和纹理模糊,同时融合时间也会增加。

深度学习方法具有强大的数据处理能力、抗干扰能力和自适应能力,因此近年来被广泛应用于图像融合领域。目前,基于深度学习的图像融合方法主要包括卷积神经网络方法[11-15]、生成对抗网络方法[16-18]和基于Transformer的方法[19-20]。Liu Yu等[14]通过卷积神经网络计算拉普拉斯变换中的高斯金字塔和拉普拉斯系数,然后重构出融合图像。Li Hui等[15]首先通过残差连接设计了一种由卷积层、融合层和Dense块组成的编码器,有助于从源图像中提取更多特征。王志社等[17]提出了一种基于可见光和红外图像的交互式注意力生成对抗融合算法,通过在融合层次上设计一种可学习的注意力机制来构建局部特征间的长距离关系。Li Jing等[20]提出了一种卷积导向变换框架,通过卷积特征提取模块提取局部特征,再利用Transformer 特征提取模块对图像的长距离依赖关系进行构建。深度学习方法可以实现多样性特征表达且泛化性强,但特征融合策略和特征提取模型的设计是难点,融合模型的性能在很大程度上受到二者的影响。多数深度学习方法难以平衡可见光和红外图像中的特征,导致融合图像中细节信息模糊。

针对上述问题,本文设计了一种基于多注意力机制的可见光和红外图像融合算法(Image Fusion Algorithm based on Multiple Attention Modules,IFAM)。首先采用卷积神经网络对可见光和红外图像提取图像特征;然后通过空间注意力和通道注意力模块对提取出来的特征进行交叉融合,同时利用特征中的梯度信息计算2个注意力模块输出特征的融合权值,根据权值融合2个注意力模块的输出特征;最后通过反卷积变换对图像特征进行还原,得到最终的融合图像。

1. 井下行人数据集构建

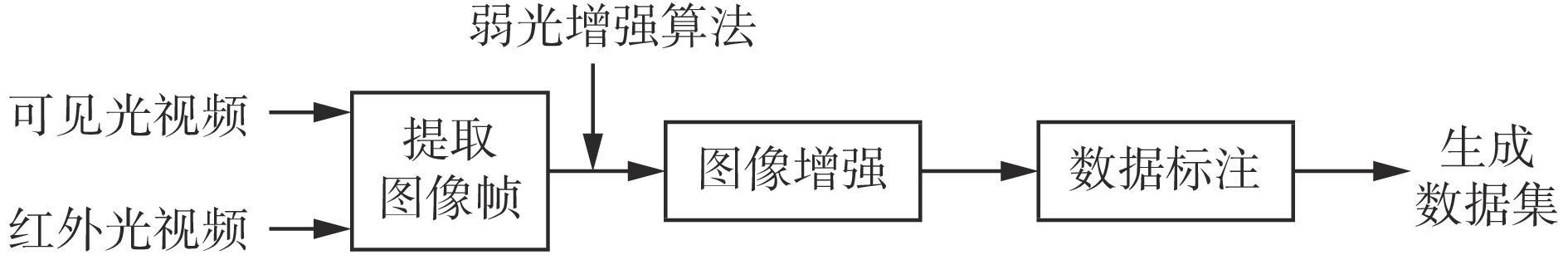

井下行人数据集构建流程如图1所示。首先使用可见光和红外传感器采集井下视频,将视频分解为图像帧;然后采用弱光增强算法EnlightenGAN[21]对图像帧中的可见光图像进行弱光增强,使之能够恢复为高对比度图像;最后对图像中的行人目标进行标注,完成井下行人数据集构建[22]。

1.1 数据采集

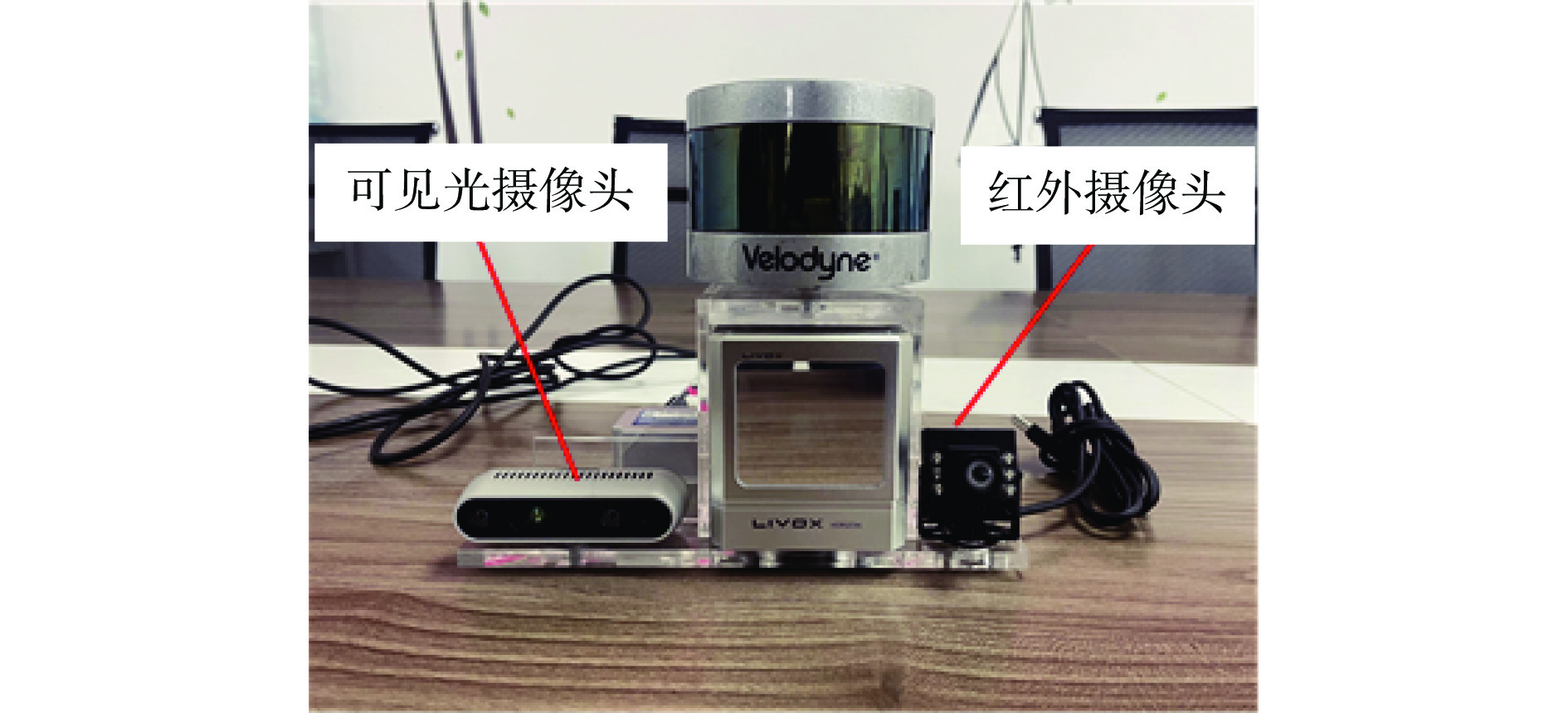

可见光图像传感器采用Intel d435i摄像头,采集图像为三通道(RGB),分辨率为 $ 640\times 640 $。为了保证图像融合时尺寸一致,红外传感器采用USB2.0红外夜视摄像头,采集图像为单通道,分辨率为 $ 640\times 640 $。摄像头采集图像时的位置如图2所示。为了使2个摄像头之间的相对位置固定,设计了传感器安装支架,支架左侧为可见光摄像头,右侧为红外摄像头,摄像头底部与支架之间采用螺栓固定。通过标定2个传感器外部参数,使采集的可见光和红外图像内容一致。摄像头采集的数据通过USB数据线传输至计算机。采集数据时,使用强磁力磁板将传感器支架固定在矿用智能车辆前车盖上。

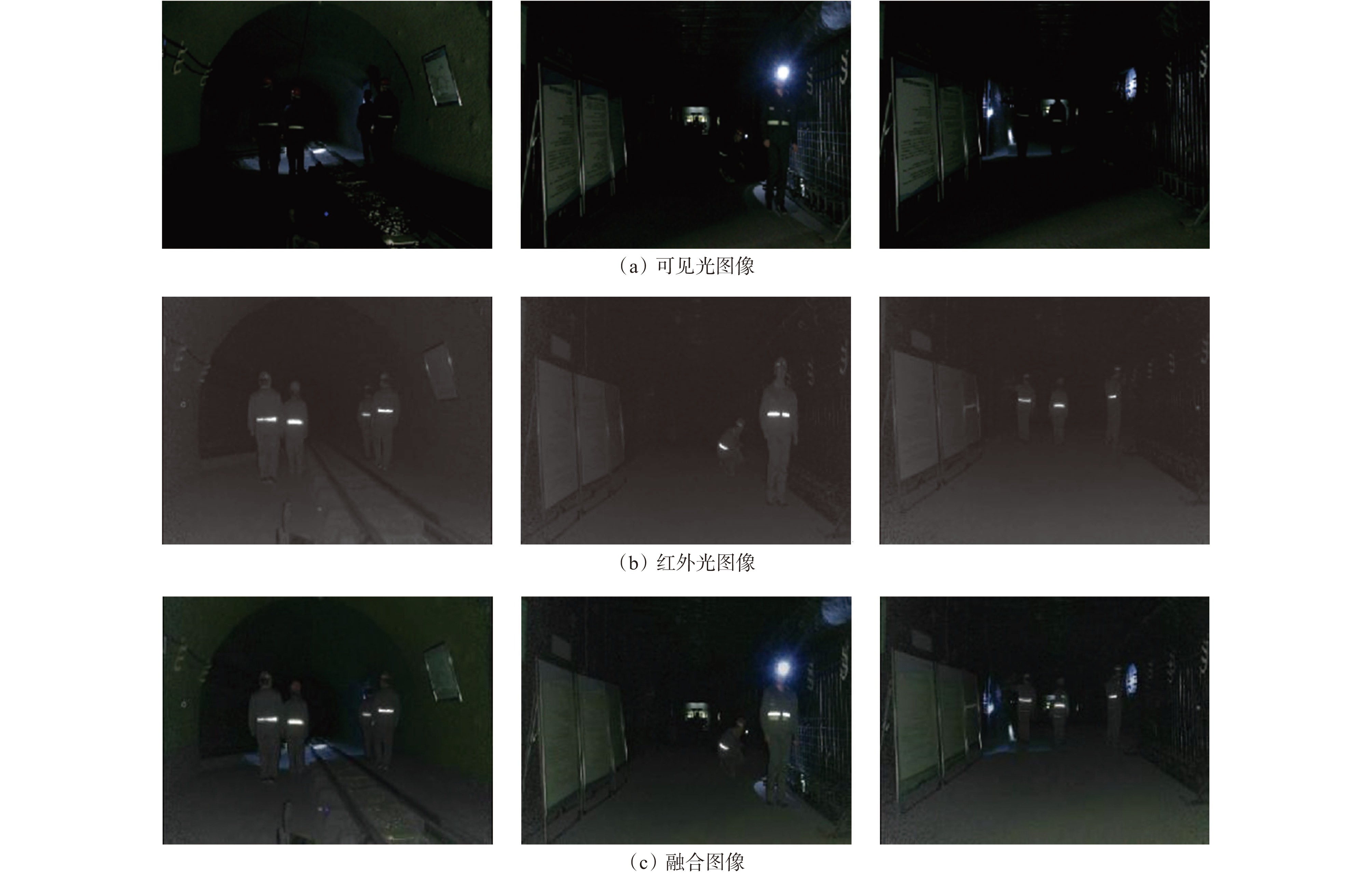

井下采集的部分可见光和红外图像如图3所示。对比2组图片可以发现:可见光图像中细节丰富,包含了场景中行人的色彩信息和背景信息;红外图像不受背景光照影响,可以在弱光情况下对行人轮廓成像,但是缺乏背景和行人的色彩信息,成像距离近。

1.2 数据标注

为了测试特有工况下融合算法的可行性,需要对井下采集到的图像进行标注。选用标注软件LabelImg进行手工标注,标注时会对标注内容生成对应的XML格式标签文件。数据集标注信息包括目标类别(行人)、目标边界框的中心点坐标、高和宽。LabelImg标注界面如图4(a)所示,标注后生成的标签文件如图4(b)所示。井下行人数据集中共10 000张图像,其中可见光和红外图像各5 000张。将数据集分为训练集和测试集,分别包含8 000,2 000张图像。

2. 可见光和红外图像融合算法

2.1 IFAM算法

2.1.1 算法框架

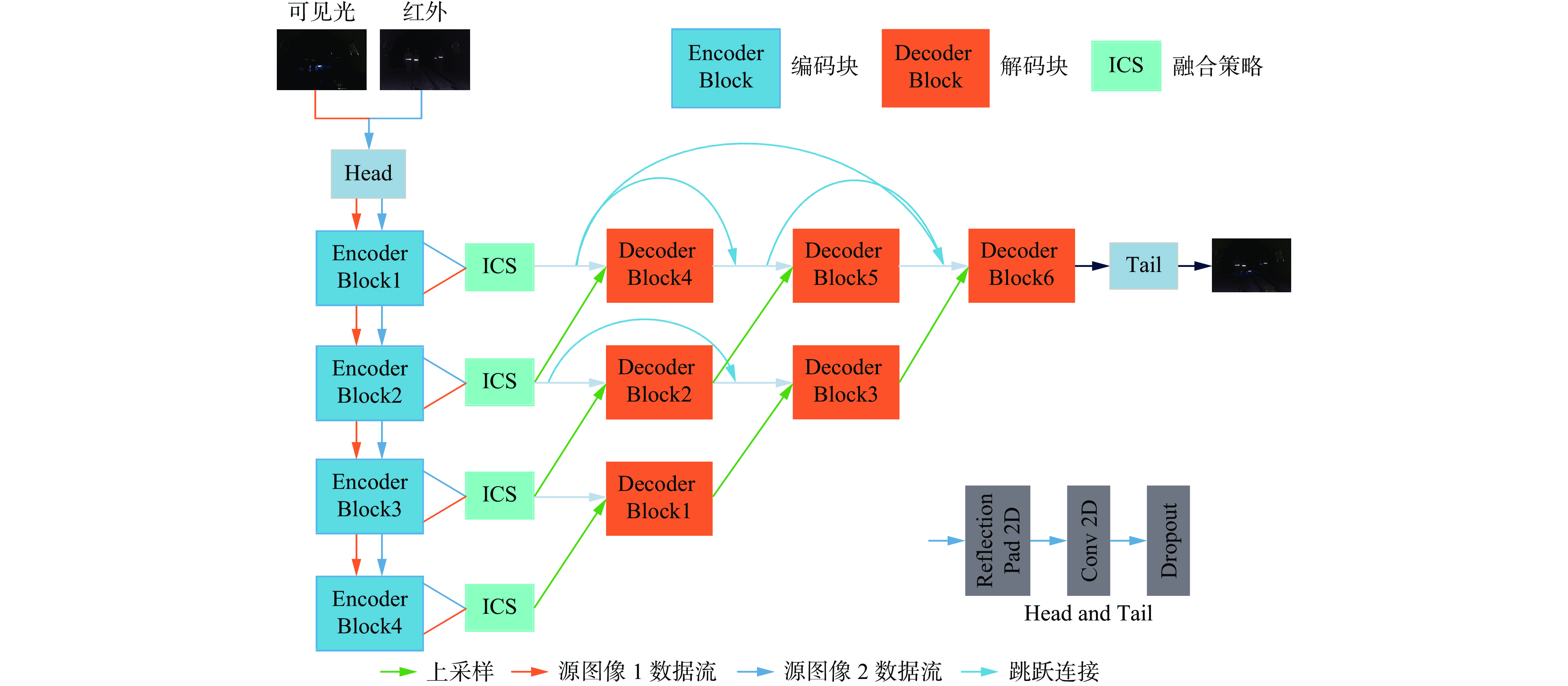

IFAM算法主要包含编码网络(Encoder Block)、特征融合模块(Information Preservation Weighted Channel and Spatial Attention,ICS)和解码网络(Decoder Block)3个部分,其中编码网络和解码网络构成了自编码−解码网络,如图5所示。首先,通过1个卷积层将源图像通道数从3增加到64,再送到1个级联了4个编码块的编码网络中分别提取特征;其次,在ICS中对提取的特征进行融合;然后,将融合特征馈送到包含6个解码块的解码网络中;最后,经过重构得到融合后的图像。

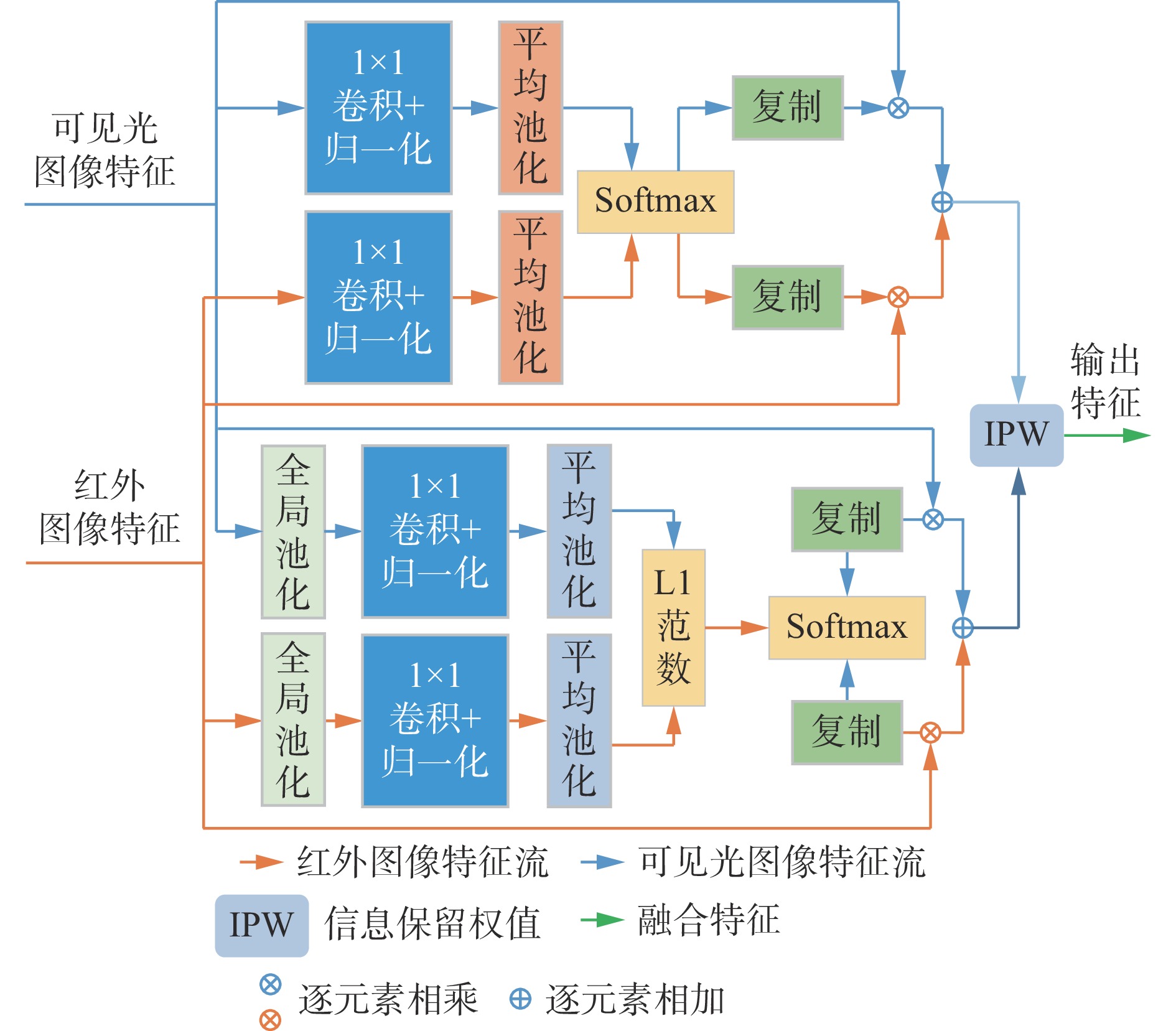

本文中的图像融合属于特征级融合,因此特征融合策略很重要。设计了一种ICS融合策略,使用通道注意力模块和空间注意力模块对图像特征中的空间和纹理信息进行关注,使得融合图像中兼具可见光图像的背景信息和红外图像的纹理信息。此外,以往的研究中一般对特征平均融合,缺乏针对性,因此,本文计算特征中梯度信息的丰富度,并对2种图像特征的丰富度求加权均值,得到融合权值。以图像特征梯度信息为依据计算自适应的融合权值,可使融合图像更为合理。

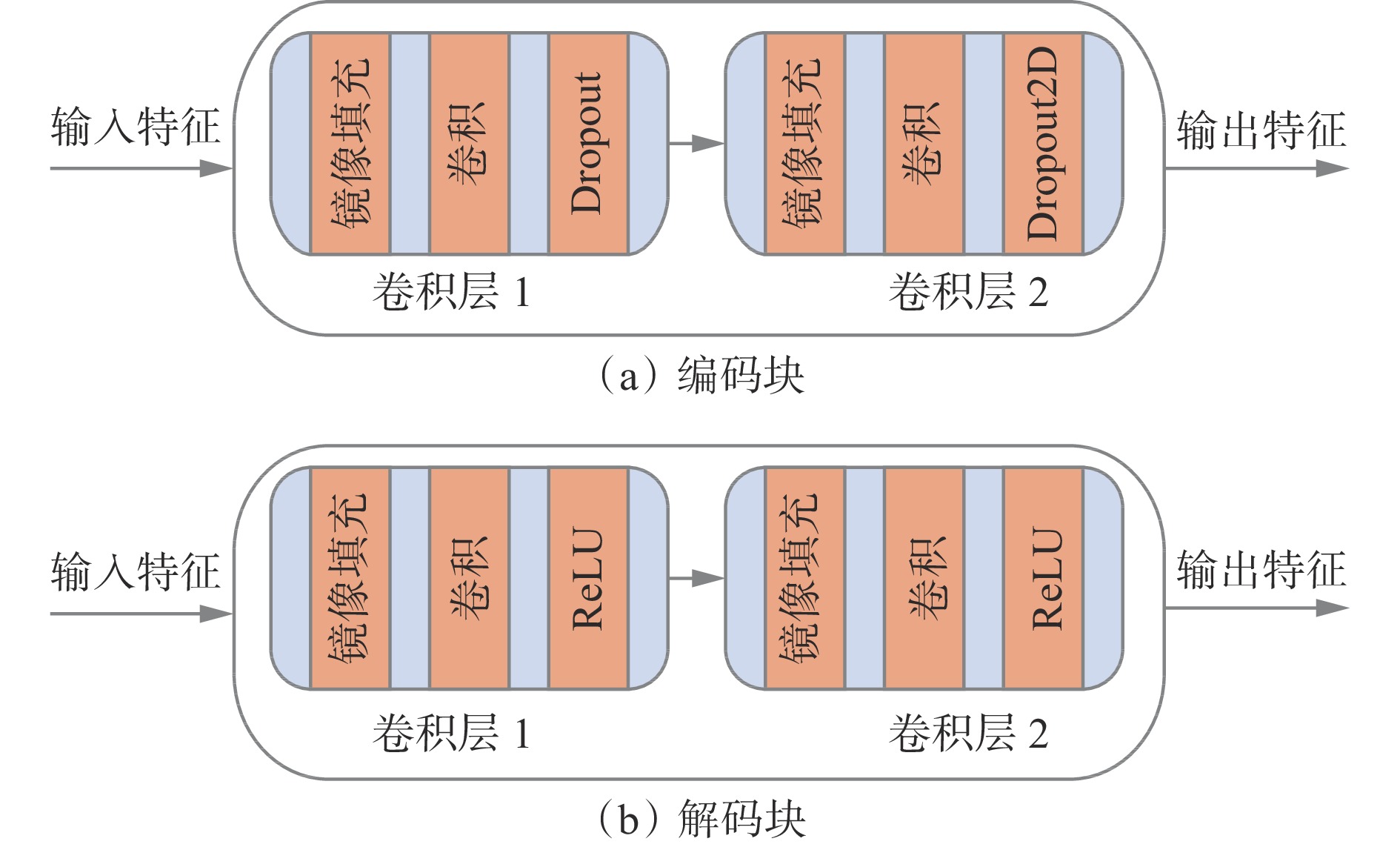

2.1.2 自编码−解码网络

自编码−解码网络配置信息见表1,包含预处理层、编码网络、解码网络和后处理层4个部分。编码网络包含4个串行连接的编码块,每个编码块中有2个卷积层,如图6(a)所示。对输入特征进行镜像填充,经过一个卷积核大小为 $ 3\times 3 $的卷积,最后对卷积中的神经元随机失活,得到第1个卷积层模型。第2个卷积层中卷积核大小为 $ 1\times 1 $。解码网络中有6个解码块,如图6(b)所示。解码块的整体结构与编码块基本相同,不同的是将卷积层中的Dropout替换为ReLU激活函数。6个解码块分别属于3个层次,最下面一层接收的特征通道数最多。同一层的解码块之间从左至右侧边连接,上一层的解码块接收下一层的输出。

表 1 自编码−解码网络配置信息Table 1. Configuration information of self-encoding and decoding network模块 网络层 卷积核

大小卷积

步长输入

通道输出

通道激活

函数预处理层 Conv 3 1 1 16 ReLU 编码网络 编码块1 − − 16 64 − 编码块2 − − 64 112 − 编码块3 − − 112 160 − 编码块4 − − 160 208 − 解码网络 解码块1 − − 368 160 − 解码块2 − − 272 112 − 解码块3 − − 384 112 − 解码块4 − − 176 64 − 解码块5 − − 240 64 − 解码块6 − − 304 64 − 后处理层 Conv 1 1 64 1 ReLU 2.1.3 基于多注意力机制的特征融合策略

注意力机制是人类视觉系统的主要特性之一。视觉信号被分成多个通道送入人脑视觉中枢系统,注意力机制可以根据不同视觉任务帮助视觉系统从复杂的通道中过滤出关键信息。根据这一特性,S. Woo等[23]提出了一种简单有效的注意力模块,促使卷积神经网络从通道和空间2个方面对特征施加不同注意力权值,从而细化特征[24]。基于多注意力机制的特征融合策略如图7所示,其中包含通道注意力模块、空间注意力模块和信息保留度权值3个部分。

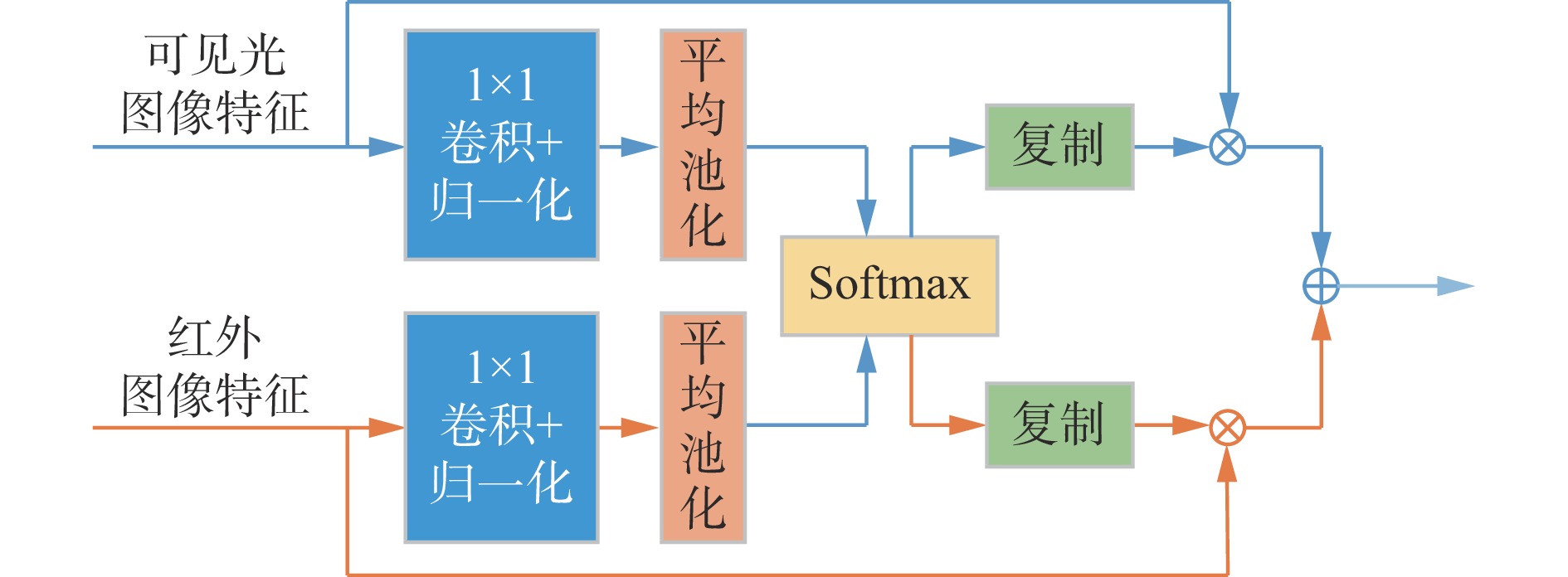

1) 通道注意力模块。通过计算2个特征图中不同通道的权值,得到通道注意力权值矩阵,如图8所示[25]。

将输入特征通过一个卷积和归一化组合的卷积层,再进行全局池化,得到初始化全局权值向量:

$$ {{\boldsymbol{w}}}_{{\rm{c}}}\left({I}_{k}\right)=G\left({\varPhi }_{i}\right({I}_{k}\left)\right) \;\;\;\;{{\boldsymbol{w}}}_{{\rm{c}}}\in {\bf{R}}^{{C}_{i}\times 1\times 1} $$ (1) 式中:Ik为源图像, $ k\in \left\{\mathrm{1,2}\right\} $,I1为红外光源图像,I2为可见光源图像; $ G\left(\cdot \right) $为逐通道平均全局池化函数; ${\varPhi }_{i} $为4个编码块从可见光和红外图像中提取出的特征图, $ i\in \left\{1,\mathrm{ }2,\mathrm{ }3,\mathrm{ }4\right\} $, $ {\varPhi }_{i}\in {\bf{R}}^{{C}_{i}\times {W}_{i}\times {H}_{i}} $, $ {C}_{i},{W}_{i},{H}_{i} $分别为特征图 $ {\varPhi }_{i} $的通道数、宽度和高度。

初始全局权值向量经过Softmax函数计算得到2个输入特征对应的权值向量。为了与输入特征逐点相乘,将权值向量拓展到与输入特征大小一致。将输入特征与拓展后的权值逐通道相乘相加,得到通道注意力模块的融合输出特征:

$$ \varPhi _{{\rm{c}}i} =\frac{{{{\boldsymbol{w}}_{\rm{c}}}({I_1})}}{{\displaystyle\sum\limits_{k = 1}^2 {{{\boldsymbol{w}}_{\rm{c}}}({I_k}) + \varepsilon } }} {\varPhi _i}({I_1}) + \frac{{{{\boldsymbol{w}}_{\rm{c}}}({I_2})}}{{\displaystyle\sum\limits_{k = 1}^2 {{{\boldsymbol{w}}_{\rm{c}}}({I_k}) + \varepsilon } }} {\varPhi _i}({I_2}) $$ (2) 式中 $ \varepsilon $为防止分母为0的常量, $\varepsilon =0.000\;1 $。

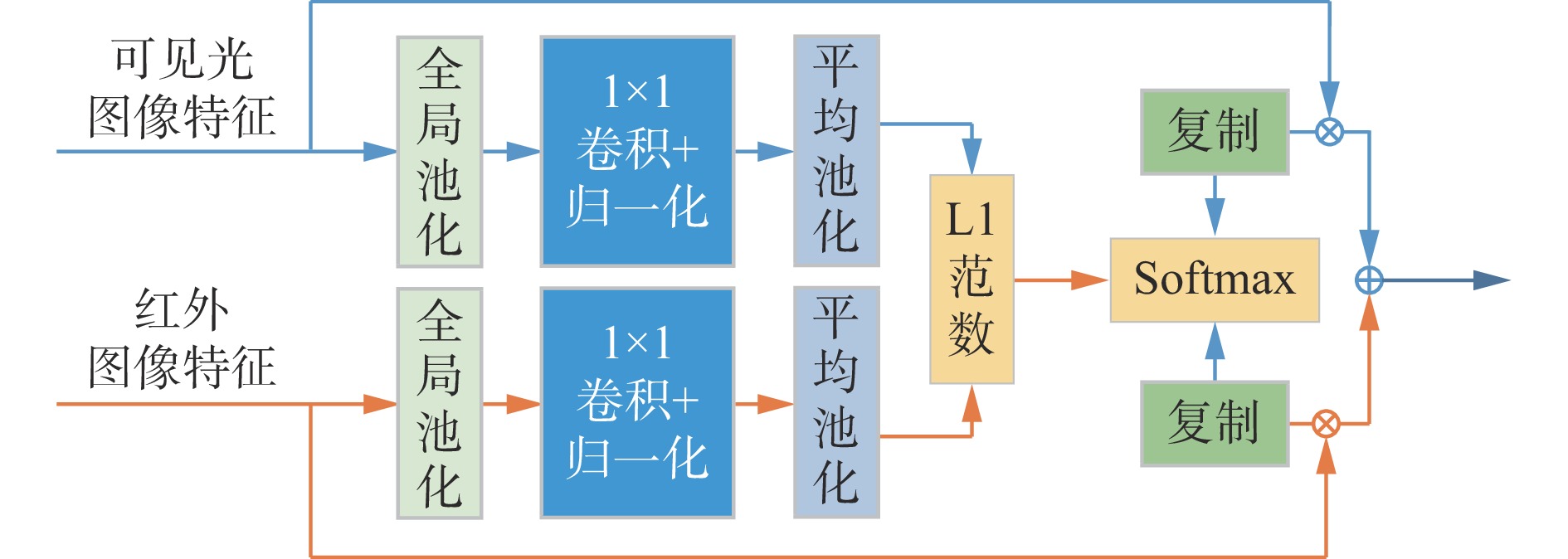

2) 空间注意力模块。该模块利用特征的空间关系生成空间注意力权值矩阵,如图9所示。文献[26]研究表明沿着通道轴施加池化操作可以有效突出显示信息区域。针对三维特征图 $ {\varPhi }_{i} $,通道注意力模块关注的是特征的每一个向量中的关系,而空间注意力模块关注的是特征的每一个平面中的关系。

对特征逐通道求和,得到初始化全局权值矩阵:

$$ {\boldsymbol{w}}_{\rm{s}}^{{I_k}} = \frac{{\displaystyle\sum\limits_{t = 1}^{C_i} {\varPhi _i^t} }}{C_i}\;\;\;\; {\boldsymbol{w}}_{\mathrm{s}}^{{I}_{k}}{\in \bf{R}}^{1\times {W}_{i}\times {H}_{i}} $$ (3) 式中 ${\varPhi _i^t} $为通道t的特征。

初始化全局权值矩阵经过L1范数和Softmax函数后取加权平均,得到最终的空间注意力权值矩阵;再将权值矩阵的维度通过复制方式扩展到Ci维;最后将拓展后的权值和输入特征分别相乘相加,得到空间注意力模块的输出特征[27]:

$$ \varPhi _{{\text{s}}i} =\frac{{{{\rm{exp}}({{\boldsymbol{w}}_{\rm{s}}^{{I_1}}})}}}{{\displaystyle\sum\limits_{k = 1}^2 {{{\rm{exp}}({{\boldsymbol{w}}_{\rm{s}}^{{I_{_k}}}})} + \varepsilon } }} {\varPhi _i}({I_1}) + \frac{{{{\rm{exp}}({{\boldsymbol{w}}_{\rm{s}}^{{I_2}}})}}}{{\displaystyle\sum\limits_{k = 1}^2 {{{\rm{exp}}({{\boldsymbol{w}}_{\rm{s}}^{{I_k}}})} + \varepsilon } }} {\varPhi _i}({I_2}) $$ (4) 3) 信息保留度权值。源图像中的信息保留度越大,该源图像对最终融合图像的影响也越大,融合特征中应该多保留一些该源图像的特征。为了再次融合通道注意力模块和空间注意力模块的输出特征,本文提出根据梯度信息估算2个融合特征中的信息保有度,再根据信息保有度计算2个融合特征再次融合的权值。图像梯度是一种基于局部空间结构的度量[28],具有较小的感受野,易计算和存储[29]。信息保留度Rz的计算公式为

$$ {R}_{{\textit{z}}}=\frac{1}{{{H}}_{{i}}{{W}}_{{i}}{{C}}_{{i}}}\sum _{{t}={1}}^{{{C}}_{{i}}}(\nabla {{{\varPhi }}_{{i}}^{{t}}\left({{O}}_{{{\textit{z}}}}\right))}^{2} $$ (5) 式中: $ \nabla $为拉普拉斯算子; $ {\varPhi }_{i}^t\left({O}_{{\textit{z}}}\right) $为第 $ {\textit{z}} $个注意力模块输出图像 $ {O}_{{\textit{z}}}$通道t的特征, $ {\varPhi }_{i}^t\left({O}_{{\textit{z}}}\right)\in {\bf{R}}^{{C}_{i}\times {W}_{i}\times {H}_{i}} $。

引入 ${\boldsymbol{w}}_{I_k} $表示自适应权值,则2个注意力模块输出特征的融合权值为

$$ \left[{{\boldsymbol{w}}}_{I_1},{{\boldsymbol{w}}}_{I_2}\right]=f\left({R}_{\mathrm{c}},{R}_{\mathrm{s}}\right) $$ (6) 式中:f(·)为 $ \mathrm{S}\mathrm{o}\mathrm{f}\mathrm{t}\mathrm{m}\mathrm{a}\mathrm{x} $函数,其作用是将2个信息保留度限制在0~1之间; $ {{R}}_{\mathrm{c}} $, $ {{R}}_{\mathrm{s}} $分别为通道注意力模块和空间注意力模块的信息保留度。

2.1.4 损失函数设计

设计损失函数时主要考虑结构相似损失 $ {L}_{\mathrm{s}\mathrm{t}\mathrm{r}\mathrm{u}\mathrm{c}\mathrm{t}\mathrm{u}\mathrm{r}\mathrm{e}} $和空间相似损失 $ {L}_{\mathrm{s}\mathrm{p}\mathrm{e}\mathrm{c}\mathrm{t}\mathrm{r}\mathrm{a}\mathrm{l}} $。结构相似损失主要约束源图像中的纹理信息,空间相似损失主要约束源图像中的像素信息。总体损失函数为

$$ L=\alpha {L}_{\mathrm{s}\mathrm{p}\mathrm{e}\mathrm{c}\mathrm{t}\mathrm{r}\mathrm{a}\mathrm{l}}+\beta {L}_{\mathrm{s}\mathrm{t}\mathrm{r}\mathrm{u}\mathrm{c}\mathrm{t}\mathrm{u}\mathrm{r}\mathrm{e}} $$ (7) 式中 $ \alpha $和 $ \beta $分别为 ${L}_{\mathrm{s}\mathrm{p}\mathrm{e}\mathrm{c}\mathrm{t}\mathrm{r}\mathrm{a}\mathrm{l}} $, ${L}_{\mathrm{s}\mathrm{t}\mathrm{r}\mathrm{u}\mathrm{c}\mathrm{t}\mathrm{u}\mathrm{r}\mathrm{e}} $的系数。

结构相似性度量(Structural Similarity Index Measure,SSIM) 是衡量图像相似性的主要评价指标之一,被广泛应用于图像融合的损失函数中,本文使用SSIM约束红外图像、可见光图像与融合图像之间的相似性。

结构相似损失计算公式为

$$ {L}_{\mathrm{s}\mathrm{t}\mathrm{r}\mathrm{u}\mathrm{c}\mathrm{t}\mathrm{u}\mathrm{r}\mathrm{e}}=1-T({U_k},{I_k}) $$ (8) 式中 $ T $为输入图像 $I_k $与重构图像 $U_k $的SSIM。

空间相似损失计算公式为

$$ {L}_{\mathrm{s}\mathrm{p}\mathrm{e}\mathrm{c}\mathrm{t}\mathrm{r}\mathrm{a}\mathrm{l}}=\frac{1}{{H_i} {W_i}}{||{I}_{{k}}-{U}_{{k}}||}_{\mathrm{F}}^{2} $$ (9) 式中: $U_{{k}} $为重构图像; $ {||\cdot ||}_{\mathrm{F}} $为F范数。

考虑到井下图像数据并不丰富,在训练编码−解码网络时先使用大型数据集COCO2014[30]中的图像进行预训练,获得初始网络权值,再加入井下图像对网络权值进行微调。训练时,损失函数中系数 $ \alpha $和 $ \beta $分别取1和100。

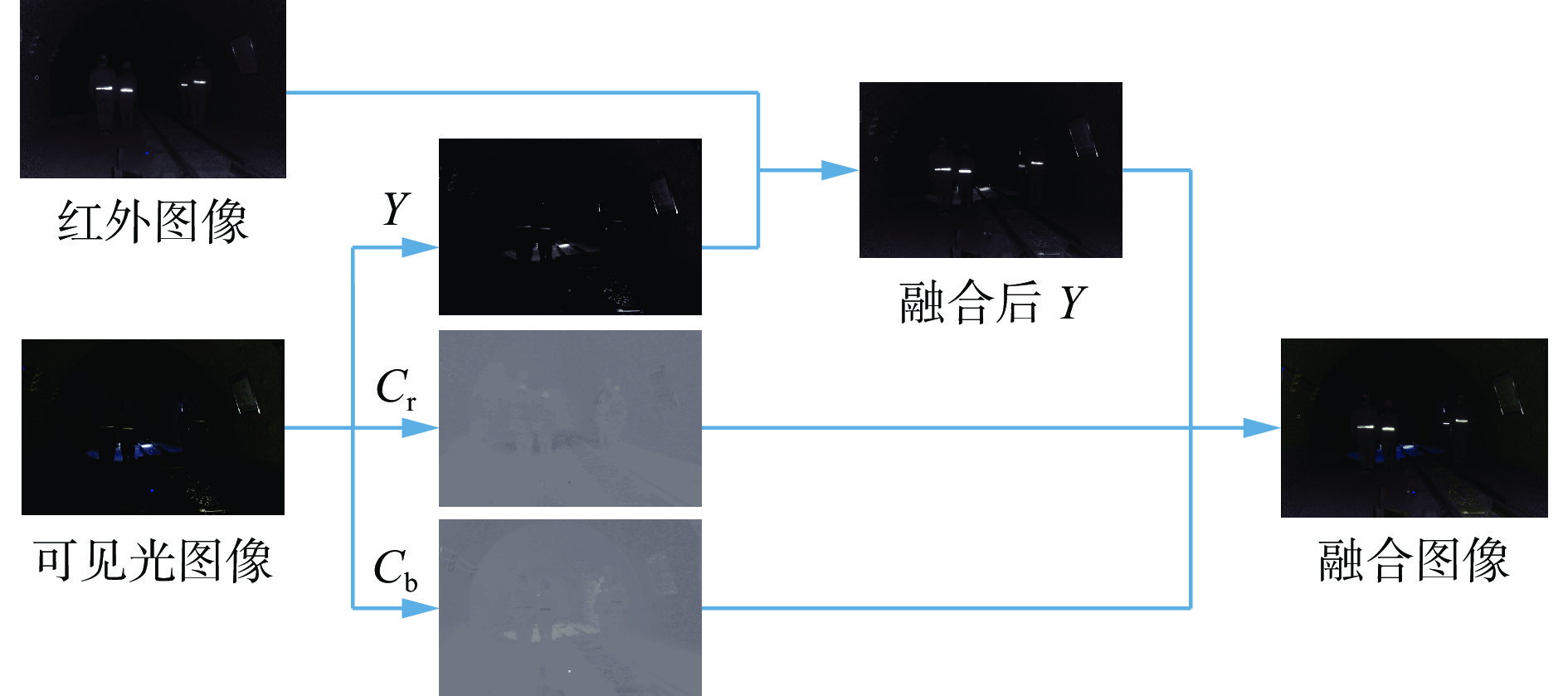

2.2 多通道和单通道图像融合

可见光图像和红外图像的格式不同,前者为彩色图像,后者为灰度图像。2个源图像通道不同,不能直接融合。为了融合彩色可见光图像和灰色红外图像,本文设计了多通道可见光图像和单通道红外图像融合策略,融合流程如图10所示。

将可见光图像分解到YCbCr图像空间,该图像空间包含3个分量,分别是亮度分量Y(luminance)、蓝色色度分量Cb(blue hue)和红色色度分量Cr(red hue)。从图10可看出,结构细节主要在亮度分量中,并且亮度分量中包含的信息比另外2个色度分量包含的信息更丰富。因此,将YCbCr空间的亮度分量与红外图像进行融合,得到融合后的亮度分量。之后,通过逆变换函数将2个色度分量与融合后的亮度分量融合,并转换到RGB图像空间。

3. 实验结果与分析

3.1 评价指标

采用5个指标来分析融合图像的质量,包括信息熵[31](Entropy,EN)、梯度融合度量指标[32](QAB/F)、融合视觉信息保真度[33](Visual Information Fidelity for Fusion,VIFF)、联合结构相似性度量(The union Structural Similarity Index Measure, $ {\mathrm{S}\mathrm{S}\mathrm{I}\mathrm{M}}_{\mathrm{u}} $)和标准方差(Standard Deviation,SD)。

EN通过计算融合图像中的信息量来评价融合图像质量。EN和图像的质量成正比,即EN值越大,图像质量越高。EN为

$$ {E}_{\mathrm{N}}=\sum _{{l}=0}^{{X}-1}{h}_{l}{\mathrm{l}\mathrm{o}\mathrm{g}}_{2}{h}_{l} $$ (10) 式中:X为图像的灰度级数量; $ {h}_{l} $为图像的归一化直方图。

梯度融合度量指标QAB/F的作用是衡量源图像和融合图像之间边缘信息的保有量[34],具体表示图像A和B融合为图像F的给定融合过程的归一化加权性能度量,其计算公式为

$$ \begin{split} &{{Q}}^{{A}{B}/{F}}=\\ &\frac{\displaystyle\sum _{{n}=1}^{{N}}\displaystyle\sum _{{m}=1}^{{M}}\left({{Q}}^{{A}{F}}\left({n},{m}\right){{W}}^{{A}}\left({n},{m}\right)+{{Q}}^{{B}{F}}\left({n},{m}\right){{W}}^{{B}}\left({n},{m}\right)\right)}{\displaystyle\sum _{{n}=1}^{{N}}\displaystyle\sum _{{m}=1}^{{M}}\left({W}^{{A}}\left({n},{m}\right)+{{W}}^{{B}}\left({n},{m}\right)\right)} \end{split}$$ (11) $$ {{Q}}^{{A}{F}}\left({n},{m}\right)={{Q}}_{{{\rm{b}}}}^{{A}{F}}\left({n},{m}\right){{Q}}_{{{\rm{a}}}}^{{A}{F}}\left({n},{m}\right) $$ (12) 式中:(n,m)为像素坐标;N,M分别为F的长和宽; $ {{Q}}^{{A}{F}}{,{Q}}^{{B}{F}} $为边缘信息保存值, 0≤QAF≤1,0≤QBF≤1,0对应于边缘信息完全丢失,1对应于边缘信息保留完整; $ {{W}}^{{A}}\left({n},{m}\right) $, $ {{W}}^{{B}}\left({n},{m}\right) $分别为 $ {{Q}}^{{A}{F}} $和 $ {{Q}}^{{B}{F}} $的权值系数; $ {{Q}}_{{{\rm{a}}}}^{{A}{F}} $, $ {{Q}}_{{{\rm{b}}}}^{{A}{F}} $分别为融合后图像与源图像的相对边缘强度和边缘方向。

VIFF是基于视觉信息保真度提出的融合图像质量评估算法,其数值与图像的质量成正比。VIFF为

$$ {V}\left({{A}},{{B}},{F}\right)=\sum _{{K}}{{p}}_{{K}} {{V}}_{{K}}\left({{A}},{{B}},{F}\right) $$ (13) 式中:pK为加权系数; $ {{V}}_{{K}}\left({{A}},{{B}},{F}\right) $为第K个子带的融合评估值。

$ {\mathrm{S}\mathrm{S}\mathrm{I}\mathrm{M}}_{\mathrm{u}} $是在结构相似度的基础上演变而来,用于评估融合图像和源图像的结构相似度。SSIMu为

$$ {{T}}_{{{\rm{u}}}}\left({F}\right)=\frac{\left({T}\left({F},{{A}}\right)+{T}\left({F},{{B}}\right)\right)}{2} $$ (14) SD的作用是衡量图像清晰度。SD与图像清晰度成正比,即SD越大,图像对比度越高,图像越清晰。SD为

$$ {S}_{{\rm{D}}}=\sqrt{\frac{1}{{M} {N}}\sum _{{n}=1}^{{N}}\sum _{{m}=1}^{{M}}{\left[{F}\left({n},{m}\right)-{{g}}_{{{\rm{m}}}{{\rm{e}}}{{\rm{a}}}{{\rm{n}}}}\left({n},{m}\right)\right]}^{2}} $$ (15) $$ {{g}}_{{{\rm{m}}}{{\rm{e}}}{{\rm{a}}}{{\rm{n}}}}=\frac{1}{{M} {N}}\sum _{{n}=1}^{{N}}\sum _{{m}=1}^{{M}}{{{F}}}\left({n},{m}\right) $$ (16) 式中 $ {{g}}_{\mathrm{m}\mathrm{e}\mathrm{a}\mathrm{n}} $为图像F的灰度均值。

3.2 实验结果和指标分析

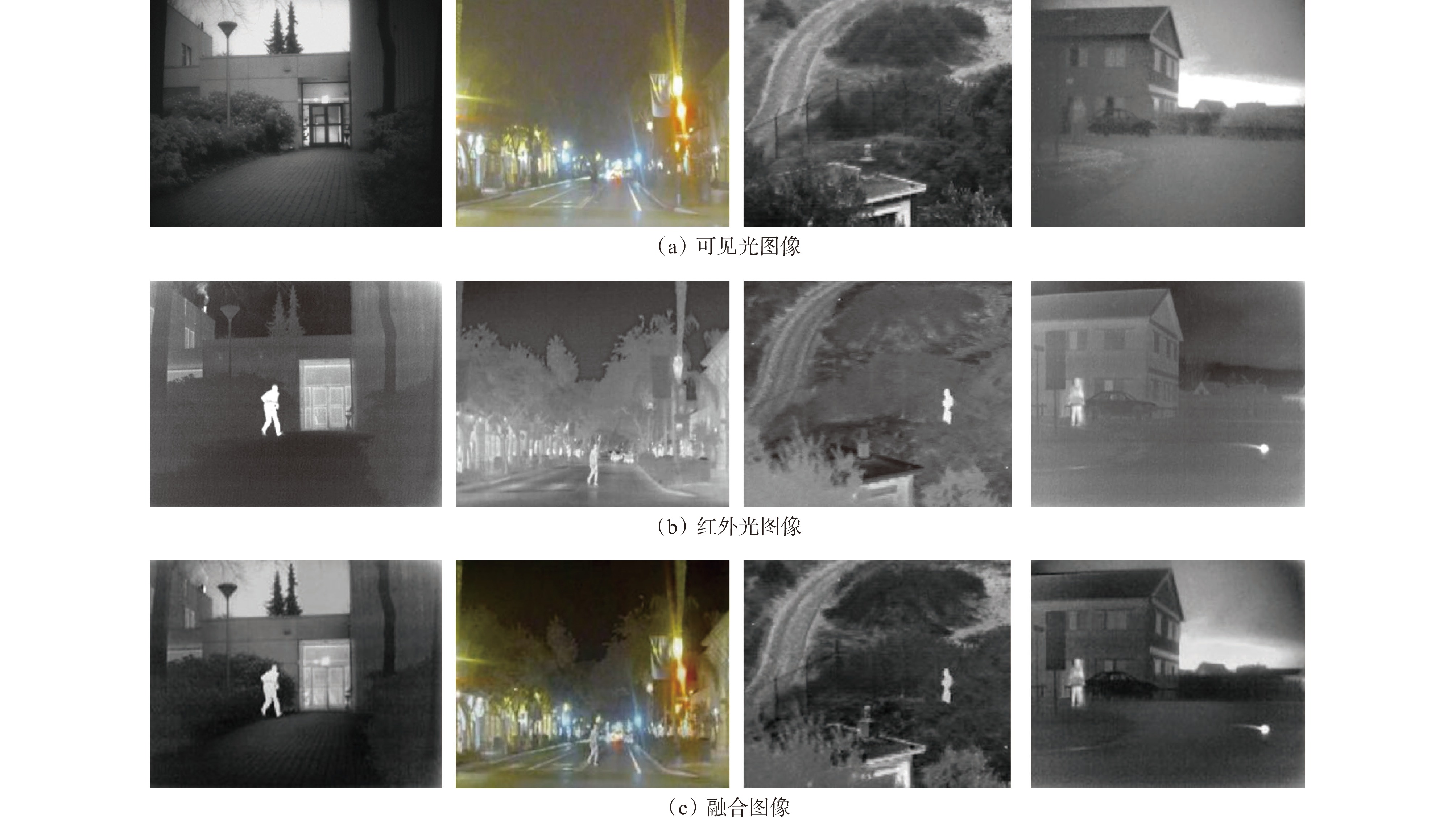

IFAM在RoadScene数据集[35]和TNO[36]数据集上的融合结果如图11所示。其中第1,3,4组为弱光图像,第2组为逆光图像。经过对比可以看出,融合后的图像中同时具备了可见光图像中的背景纹理和红外图像中的行人轮廓特征信息,经过图像融合后,图像中的行人信息更加明显,可以为行人检测网络提供更加充分的特征信息。

IFAM在井下数据集上的融合结果如图12所示。经过对比可以看出,在弱光环境下,红外图像可以弥补可见光的缺点,并且不受环境中其他光源(如手电光)的影响。在弱光条件下融合后的图像中行人轮廓依旧明显。

选用5种性能优异的图像融合算法进行对比分析,分别为LLF−IOI[37]、NDM[38]、PA−PCNN[39]、TA−cGAN[40]和U2fuse[29],结果见表2。可看出,本文提出的IFAM的SD和SSIMu分别为88.015 5和0.791 6,高于其他算法,EN,QAB/F,VIFF分别为4.901 3,0.169 3,1.413 5。从指标数据可知,通过通道和空间注意力机制融合图像特征可以避免可见光的纹理信息被红外图像的灰度信息淡化,使得融合图像中的结构信息更加明显;信息保留度权值能够平衡可见光和红外图像特征在融合特征中的占比,避免图像模糊。

表 2 图像融合算法在井下数据集上的指标数据Table 2. Index data of image fusion algorithm on underground dataset算法 SD EN QAB/F VIFF SSIMu LLF−IOI 83.396 2 5.147 2 0.164 7 1.154 5 0.647 5 NDM 69.575 9 5.212 6 0.168 7 1.216 9 0.753 6 PA−PCNN 85.478 9 5.363 4 0.165 4 1.496 3 0.758 6 TA−cGAN 85.446 8 5.442 5 0.203 6 1.425 4 0.723 0 U2fuse 76.093 6 5.502 3 0.123 9 0.832 9 0.473 2 IFAM 88.521 4 4.901 3 0.169 3 1.413 5 0.806 2 3.3 消融实验分析

第1个消融实验目的是证明融合策略中3个模型之间组合的合理性,分析不同注意力模块组合对融合结果的影响。通道注意力模块可以保留更多结构信息,但降低了图像前景和背景之间的对比度。空间注意力模块可以获得良好的对比度,但模糊了纹理信息。通道和空间注意力改善了纹理的模糊效果,但忽略了对比度。本文提出的基于多注意力机制的特征融合策略不仅改善了纹理信息,还提高了前景和背景的对比度。针对通道注意力模块、空间注意力模块和信息保留度权值模块的消融实验结果见表3。可看出,基于多注意力机制的特征融合策略的EN,SD,VIFF, $ {\mathrm{S}\mathrm{S}\mathrm{I}\mathrm{M}}_{\mathrm{u}} $优于其他组合。与单个注意力模块相比,具有信息保留权值的特征融合策略取得了更显著的效果。

表 3 基于多注意力机制的特征融合策略中各模块消融实验结果Table 3. Experimental results of ablation of each module in feature fusion strategy based on multi attention mechanism通道

注意力空间

注意力信息保留

度权值EN SD QAB/F VIFF SSIMu √ 5.003 1 75.254 8 0.089 3 0.152 0 0.450 1 √ 5.089 6 70.521 7 0.082 7 0.178 2 0.447 1 √ √ 4.836 9 82.862 7 0.112 9 0.110 4 0.462 4 √ √ √ 5.112 3 83.521 3 0.089 3 0.183 6 0.470 3 第2个消融实验目的是探究损失函数中2个超参数的最佳值组合,即 $ \alpha $和 $ \beta $最佳组合。实验中, $ \alpha $设置为0.1,0.5,1, $ \beta $设置为1,10,100,1 000。不同 $ \alpha $和 $ \beta $组合下IFAM的实验结果见表4。可看出,当 $ \alpha < $0.5且 $ \beta < $100时,在5个指标上综合表现较差;当 $ \alpha $=1, $ \beta $=1 000时,虽然融合图像的SD和 $ {{Q}}^{{A}{B}/{F}} $较大,但是其他3个指标较小,因为局部亮度的增加导致结构信息被覆盖,使得融合图像更加模糊。综合对比结果, $ \alpha =1 $和 $ \beta =100 $是最佳组合。

表 4 不同 $ \alpha $和 $ \beta $组合下IFAM的实验结果Table 4. Experimental results of IFAM under different combinations of α and β$ \alpha $ $ \beta $ EN SD QAB/F VIFF $ {\mathrm{S}\mathrm{S}\mathrm{I}\mathrm{M}}_{\mathrm{u}} $ $ 0.1 $ $ 1 $ 3.309 7 58.659 3 0.063 9 0.814 7 0.438 7 $ 10 $ 3.600 7 60.078 0 0.058 0 0.909 1 0.476 5 $ 100 $ 3.452 6 63.853 6 0.106 5 1.065 6 0.556 3 $ 1\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }000 $ 4.325 5 64.241 7 0.106 4 1.149 8 0.545 6 $ 0.5 $ $ 1 $ 4.063 4 60.933 6 0.013 2 1.234 1 0.596 7 $ 10 $ 4.383 7 63.111 1 0.104 5 1.133 1 0.565 7 $ 100 $ 4.115 9 73.417 1 0.109 9 1.334 1 0.676 7 $ 1\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }000 $ 4.296 1 74.569 5 0.116 4 1.421 5 0.643 2 $ 1 $ $ 1 $ 4.147 5 68.942 3 0.165 8 1.165 7 0.563 4 $ 10 $ 4.308 9 73.922 1 0.145 6 1.134 4 0.624 5 $ 100 $ 4.391 5 76.345 5 0.121 3 1.480 2 0.705 0 $ 1\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }000 $ 4.051 7 76.876 9 0.125 6 1.265 2 0.578 5 4. 结论

1) 提出了用于井下智能车辆行人检测的图像融合算法IFAM。首先采用自编码器对可见光和红外图像进行特征提取,其次采用空间注意力机制和通道注意力机制融合从可见光和红外图像中提取的特征,然后采用基于梯度信息方法计算空间注意力机制和通道注意力机制输出特征的融合权值,融合2个注意力机制处理后的特征,最后通过解码器还原出融合图像。

2) 在RoadScene数据集、TNO数据集及井下数据集上的融合结果表明,IFAM能够有效融合图像,经IFAM融合后的图像中同时具备可见光图像中的背景纹理和红外图像中的行人轮廓特征信息,在弱光条件下融合后的图像中行人轮廓依旧明显。

3) 对比分析结果表明,经IFAM融合后图像的EN,SD,QAB/F,VIFF, $ {\mathrm{S}\mathrm{S}\mathrm{I}\mathrm{M}}_{\mathrm{u}} $分别为4.901 3,88.521 4,0.169 3,1.413 5,0.806 2,整体性能优于同类的LLF−IOI、NDM等算法。

4) 消融实验结果表明:与单个注意力模块相比,具有信息保留权值的多注意力特征融合策略取得了更显著的效果;损失函数中超参数α=1,β=100是最佳组合。

-

表 1 自编码−解码网络配置信息

Table 1 Configuration information of self-encoding and decoding network

模块 网络层 卷积核

大小卷积

步长输入

通道输出

通道激活

函数预处理层 Conv 3 1 1 16 ReLU 编码网络 编码块1 − − 16 64 − 编码块2 − − 64 112 − 编码块3 − − 112 160 − 编码块4 − − 160 208 − 解码网络 解码块1 − − 368 160 − 解码块2 − − 272 112 − 解码块3 − − 384 112 − 解码块4 − − 176 64 − 解码块5 − − 240 64 − 解码块6 − − 304 64 − 后处理层 Conv 1 1 64 1 ReLU 表 2 图像融合算法在井下数据集上的指标数据

Table 2 Index data of image fusion algorithm on underground dataset

算法 SD EN QAB/F VIFF SSIMu LLF−IOI 83.396 2 5.147 2 0.164 7 1.154 5 0.647 5 NDM 69.575 9 5.212 6 0.168 7 1.216 9 0.753 6 PA−PCNN 85.478 9 5.363 4 0.165 4 1.496 3 0.758 6 TA−cGAN 85.446 8 5.442 5 0.203 6 1.425 4 0.723 0 U2fuse 76.093 6 5.502 3 0.123 9 0.832 9 0.473 2 IFAM 88.521 4 4.901 3 0.169 3 1.413 5 0.806 2 表 3 基于多注意力机制的特征融合策略中各模块消融实验结果

Table 3 Experimental results of ablation of each module in feature fusion strategy based on multi attention mechanism

通道

注意力空间

注意力信息保留

度权值EN SD QAB/F VIFF SSIMu √ 5.003 1 75.254 8 0.089 3 0.152 0 0.450 1 √ 5.089 6 70.521 7 0.082 7 0.178 2 0.447 1 √ √ 4.836 9 82.862 7 0.112 9 0.110 4 0.462 4 √ √ √ 5.112 3 83.521 3 0.089 3 0.183 6 0.470 3 表 4 不同 $ \alpha $和 $ \beta $组合下IFAM的实验结果

Table 4 Experimental results of IFAM under different combinations of α and β

$ \alpha $ $ \beta $ EN SD QAB/F VIFF $ {\mathrm{S}\mathrm{S}\mathrm{I}\mathrm{M}}_{\mathrm{u}} $ $ 0.1 $ $ 1 $ 3.309 7 58.659 3 0.063 9 0.814 7 0.438 7 $ 10 $ 3.600 7 60.078 0 0.058 0 0.909 1 0.476 5 $ 100 $ 3.452 6 63.853 6 0.106 5 1.065 6 0.556 3 $ 1\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }000 $ 4.325 5 64.241 7 0.106 4 1.149 8 0.545 6 $ 0.5 $ $ 1 $ 4.063 4 60.933 6 0.013 2 1.234 1 0.596 7 $ 10 $ 4.383 7 63.111 1 0.104 5 1.133 1 0.565 7 $ 100 $ 4.115 9 73.417 1 0.109 9 1.334 1 0.676 7 $ 1\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }000 $ 4.296 1 74.569 5 0.116 4 1.421 5 0.643 2 $ 1 $ $ 1 $ 4.147 5 68.942 3 0.165 8 1.165 7 0.563 4 $ 10 $ 4.308 9 73.922 1 0.145 6 1.134 4 0.624 5 $ 100 $ 4.391 5 76.345 5 0.121 3 1.480 2 0.705 0 $ 1\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }\mathrm{ }000 $ 4.051 7 76.876 9 0.125 6 1.265 2 0.578 5 -

[1] 周李兵. 煤矿井下无轨胶轮车无人驾驶系统研究[J]. 工矿自动化,2022,48(6):36-48. ZHOU Libing. Research on unmanned driving system of underground trackless rubber-tyred vehicle in coal mine[J]. Journal of Mine Automation,2022,48(6):36-48.

[2] MA Jiayi,MA Yong,LI Chang. Infrared and visible image fusion methods and applications:a survey[J]. Information Fusion,2019,45:153-178. DOI: 10.1016/j.inffus.2018.02.004

[3] WANG Zhishe,XU Jiawei,JIANG Xiaolin,et al. Infrared and visible image fusion via hybrid decomposition of NSCT and morphological sequential toggle operator[J]. Optik,2020,201. DOI: 10.1016/j.ijleo.2019.163497.

[4] MALLAT S G. A theory for multiresolution signal decomposition:the wavelet representation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,1989,11(7):674-693. DOI: 10.1109/34.192463

[5] 肖杨,张凌雪,付玲. Contourlet变换及方向滤波器组设计相关问题[J]. 科技风,2009(23):221. DOI: 10.3969/j.issn.1671-7341.2009.23.199 XIAO Yang,ZHANG Lingxue,FU Ling. Problems related to Contourlet transformation and directional filter bank design[J]. Technology Wind,2009(23):221. DOI: 10.3969/j.issn.1671-7341.2009.23.199

[6] DA CUNHA A L,ZHOU Jianping,DO M N. The nonsubsampled contourlet transform:theory,design,and applications[J]. IEEE Transactions on Image Processing,2006,15(10):3089-3101. DOI: 10.1109/TIP.2006.877507

[7] 罗娟,王立平. 基于非下采样Contourlet变换耦合特征选择机制的可见光与红外图像融合算法[J]. 电子测量与仪器学报,2021,35(7):163-169. LUO Juan,WANG Liping. Infrared and visible image fusion algorithm based on nonsubsampled contourlet transform coupled with feature selection mechanism[J]. Journal of Electronic Measurement and Instrumentation,2021,35(7):163-169.

[8] GAO Ce,QI Donghao,ZHANG Yanchao,et al. Infrared and visible image fusion method based on ResNet in a nonsubsampled contourlet transform domain[J]. IEEE Access,2021,9:91883-91895. DOI: 10.1109/ACCESS.2021.3086096

[9] 詹玲超,刘瑾. 基于非下采样Contourlet变换红外和可见光图像的融合方法[J]. 数字技术与应用,2016(10):45-46. ZHAN Lingchao,LIU Jin. Infrared and visible image fusion method based on nonsubsampled contourlet transform[J]. Digital Technology and Application,2016(10):45-46.

[10] FARBMAN Z,FATTAL R,LISCHINSKI D,et al. Edge-preserving decompositions for multi-scale tone and detail manipulation[J]. ACM Transactions on Graphics,2008,27(3):1-10.

[11] ZHANG Yu,LIU Yu,SUN Peng,et al. IFCNN:a general image fusion framework based on convolutional neural network[J]. Information Fusion,2020,54:99-118. DOI: 10.1016/j.inffus.2019.07.011

[12] LI Hui,WU Xiaojun,KITTLER J. RFN-Nest:an end-to-end residual fusion network for infrared and visible images[J]. Information Fusion,2021,73:72-86. DOI: 10.1016/j.inffus.2021.02.023

[13] WANG Zhishe,WANG Junyao,WU Yuanyuan,et al. UNFusion:a unified multi-scale densely connected network for infrared and visible image fusion[J]. IEEE Transactions on Circuits and Systems for Video Technology,2022,32(6):3360-3374. DOI: 10.1109/TCSVT.2021.3109895

[14] LIU Yu,CHEN Xun,CHENG Juan,et al. Infrared and visible image fusion with convolutional neural networks[J]. International Journal of Wavelets,Multiresolution and Information Processing,2018,16(3). DOI: 10.1142/S0219691318500182.

[15] LI Hui,WU Xiaojun. DenseFuse:a fusion approach to infrared and visible images[J]. IEEE Transactions on Image Processing,2018,28(5):2614-2623.

[16] 罗迪,王从庆,周勇军. 一种基于生成对抗网络与注意力机制的可见光和红外图像融合方法[J]. 红外技术,2021,43(6):566-574. LUO Di,WANG Congqing,ZHOU Yongjun. A visible and infrared image fusion method based on generative adversarial networks and attention mechanism[J]. Infrared Technology,2021,43(6):566-574.

[17] 王志社,邵文禹,杨风暴,等. 红外与可见光图像交互注意力生成对抗融合方法[J]. 光子学报,2022,51(4):318-328. WANG Zhishe,SHAO Wenyu,YANG Fengbao,et al. Infrared and visible image fusion method via interactive attention based generative adversarial network[J]. Acta Photonica Sinica,2022,51(4):318-328.

[18] MA Jiayi,ZHANG Hao,SHAO Zhenfeng,et al. GANMcC:a generative adversarial network with multiclassification constraints for infrared and visible image fusion[J]. IEEE Transactions on Instrumentation and Measurement,2021,70:1-14.

[19] RAO Dongyu,WU Xiaojun,XU Tianyang. TGFuse:an infrared and visible image fusion approach based on transformer and generative adversarial network[EB/OL]. [2023-06-20]. https://arxiv.org/abs/2201.10147.

[20] LI Jing,ZHU Jianming,LI Chang,et al. CGTF:convolution-guided transformer for infrared and visible image fusion[J]. IEEE Transactions on Instrumentation and Measurement,2022,71:1-14.

[21] JIANG Yifan,GONG Xinyu,LIU Ding,et al. EnlightenGAN:deep light enhancement without paired supervision[J]. IEEE Transactions on Image Processing,2021,30:2340-2349. DOI: 10.1109/TIP.2021.3051462

[22] 秦沛霖,张传伟,周李兵,等. 煤矿井下无人驾驶无轨胶轮车目标3D检测研究[J]. 工矿自动化,2022,48(2):35-41. QIN Peilin,ZHANG Chuanwei,ZHOU Libing,et al. Research on 3D target detection of unmanned trackless rubber-tyred vehicle in coal mine[J]. Industry and Mine Automation,2022,48(2):35-41.

[23] WOO S,PARK J,LEE J-Y,et al. CBAM:convolutional block attention module[C]. 15th European Conference on Computer Vision,Munich,2018:3-19.

[24] 梁美彦,张倩楠,任竹云,等. 基于注意力机制的结肠癌病理学图像识别研究[J]. 测试技术学报,2022,36(2):93-100. LIANG Meiyan,ZHANG Qiannan,REN Zhuyun,et al. Research on identification of colon pathology image based on attention mechanism[J]. Journal of Test and Measurement Technology,2022,36(2):93-100.

[25] 牛悦,王安南,吴胜昔. 基于注意力机制和级联金字塔网络的姿态估计[J/OL]. 华东理工大学学报(自然科学版):1-11[2023-06-20]. DOI: 10.14135/j.cnki.1006-3080.20220715003. NIU Yue,WANG Annan,WU Shengxi. Pose estimation based on attention module and CPN[J/OL]. Journal of East China University of Science and Technology(Natural Science Edition):1-11[2023-06-20]. DOI: 10.14135/j.cnki.1006-3080.20220715003.

[26] ZAGORUYKO S,KOMODAKIS N. Paying more attention to attention:improving the performance of convolutional neural networks via attention transfer[EB/OL]. [2023-06-20]. https://arxiv.org/abs/1612.03928v2.

[27] 陈舞,孙军梅,李秀梅. 融合多尺度残差和注意力机制的特发性肺纤维化进展预测[J]. 中国图象图形学报,2022,27(3):812-826. CHEN Wu,SUN Junmei,LI Xiumei. Multi-scale residual and attention mechanism fusion based prediction for the progression of idiopathic pulmonary fibrosis[J]. Journal of Image and Graphics,2022,27(3):812-826.

[28] 李国梁,向文豪,张顺利,等. 基于残差网络和注意力机制的红外与可见光图像融合算法[J]. 无人系统技术,2022,5(2):9-21. LI Guoliang,XIANG Wenhao,ZHANG Shunli,et al. Infrared and visible image fusion algorithm based on residual network and attention mechanism[J]. Unmanned Systems Technology,2022,5(2):9-21.

[29] XU Han,MA Jiayi,JIANG Junjun,et al. U2Fusion:a unified unsupervised image fusion network[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2020,44(1):502-518.

[30] LIN T-Y,MAIRE M,BELONGIE S,et al. Microsoft COCO:common objects incontext[C]. 13th European Conference on Computer Vision,Zurich,2014:740-755.

[31] ROBERTS J W,VAN AARDT J A,AHMED F B. Assessment of image fusion procedures using entropy,image quality,and multispectral classification[J]. Journal of Applied Remote Sensing,2008,2(1). DOI: 10.1117/1.2945910.

[32] XYDEAS C,PETROVIC V. Objective image fusion performance measure[J]. Electronics Letters,2000,36(4):308-309. DOI: 10.1049/el:20000267

[33] HAN Yu,CAI Yunze,CAO Yin,et al. A new image fusion performance metric based on visual information fidelity[J]. Information Fusion,2013,14(2):127-135. DOI: 10.1016/j.inffus.2011.08.002

[34] 吴明辉. 联合特征提取方法的图像融合技术研究[D]. 武汉:武汉大学,2021. WU Minghui. Research on image fusion based on joint feature extraction[D]. Wuhan:Wuhan University,2021.

[35] XU Han. RoadScene:a new dataset of aligned infrared and visible images[DB/OL]. [2023-06-07]. https://github.com/hanna-xu/RoadScene.

[36] TOET A. TNO image fusion datase[DB/OL]. [2023-06-26]. https://figshare.com/articles/dataset/TNO_Image_Fusion_Dataset/1008029.

[37] DU Jiao,LI Weisheng,XIAO Bin. Anatomical-functional image fusion by information of interest in local Laplacian filtering domain[J]. IEEE Transactions on Image Processing,2017,26(12):5855-5866. DOI: 10.1109/TIP.2017.2745202

[38] LIU Zhe,SONG Yuqing,SHENG V S,et al. MRI and PET image fusion using the nonparametric density model and the theory of variable-weight[J]. Computer Methods and Programs in Biomedicine,2019,175:73-82. DOI: 10.1016/j.cmpb.2019.04.010

[39] YIN Ming,LIU Xiaoning,LIU Yu,et al. Medical image fusion with parameter-adaptive pulse coupled neural network in nonsubsampled shearlet transform domain[J]. IEEE Transactions on Instrumentation and Measurement,2018,68(1):49-64.

[40] KANG Jiayin,LU Wu,ZHANG Wenjuan. Fusion of brain PET and MRI images using tissue-aware conditional generative adversarial network with joint loss[J]. IEEE Access,2020,8:6368-6378. DOI: 10.1109/ACCESS.2019.2963741

-

期刊类型引用(1)

1. 张娜,彭文韬,赵强,汝洪芳,吴信元. 基于MBE-YOLO的轻量化井下行人检测模型. 矿业研究与开发. 2025(05): 192-199 .  百度学术

百度学术

其他类型引用(1)

下载:

下载: