0 引言

煤矿安全是安全生产的重中之重。我国发生煤矿安全事故的因素一方面是自然地质条件、产业结构及现有开采条件,另一方面是从业人员素质低下及监管措施不到位[1-2]。后者属于人为可控因素,可通过井下视频监控系统及行人检测方法对井下人员位置和行为进行检测与识别,从而提高井下监管效率,及时发现安全隐患[3-4]。

行人检测方法可分为基于特征提取和基于深度学习两类。其中基于特征提取的行人检测方法采用人工设计特征提取器,通过提取HOG特征[5]、Haar特征[6]、LBP特征[7]、积分通道特征[8]等训练分类器,进而实现行人检测。该方法需根据不同应用场景设计特定的特征提取器,难以适应复杂场景,泛化能力差。近年来,随着深度学习理论的快速发展,基于深度学习的行人检测方法取得了很大进步[9-12],在检测精度、速度方面较基于特征提取的行人检测方法有很大提高。研究表明,利用深度学习自动获取的特征可以更好地描述待检测目标的特性,避免了复杂的特征提取和数据建模过程,具有更高的应用价值。但现有基于深度学习的行人检测方法存在计算量大、检测效率严重依赖硬件性能等问题,因此,本文在SSD(Single Shot MultiBox Detector)网络[13]基础上对其进行改进,设计了轻量级卷积神经网络作为SSD网络的基础网络及基于ResNet网络[14]的辅助网络,并在嵌入式平台Jetson TX2上部署应用基于改进SSD网络的井下视频行人检测方法,获得了较好的准确性和实时性。

1 SSD网络

SSD是一种单阶段端到端目标检测算法,是目前主要的检测框架之一[15]。SSD借鉴Faster R-CNN的anchors机制[14]和YOLO回归思想[16],采用小尺寸的卷积核和多尺度特征预测方式,极大提高了检测速度和目标检测精度。

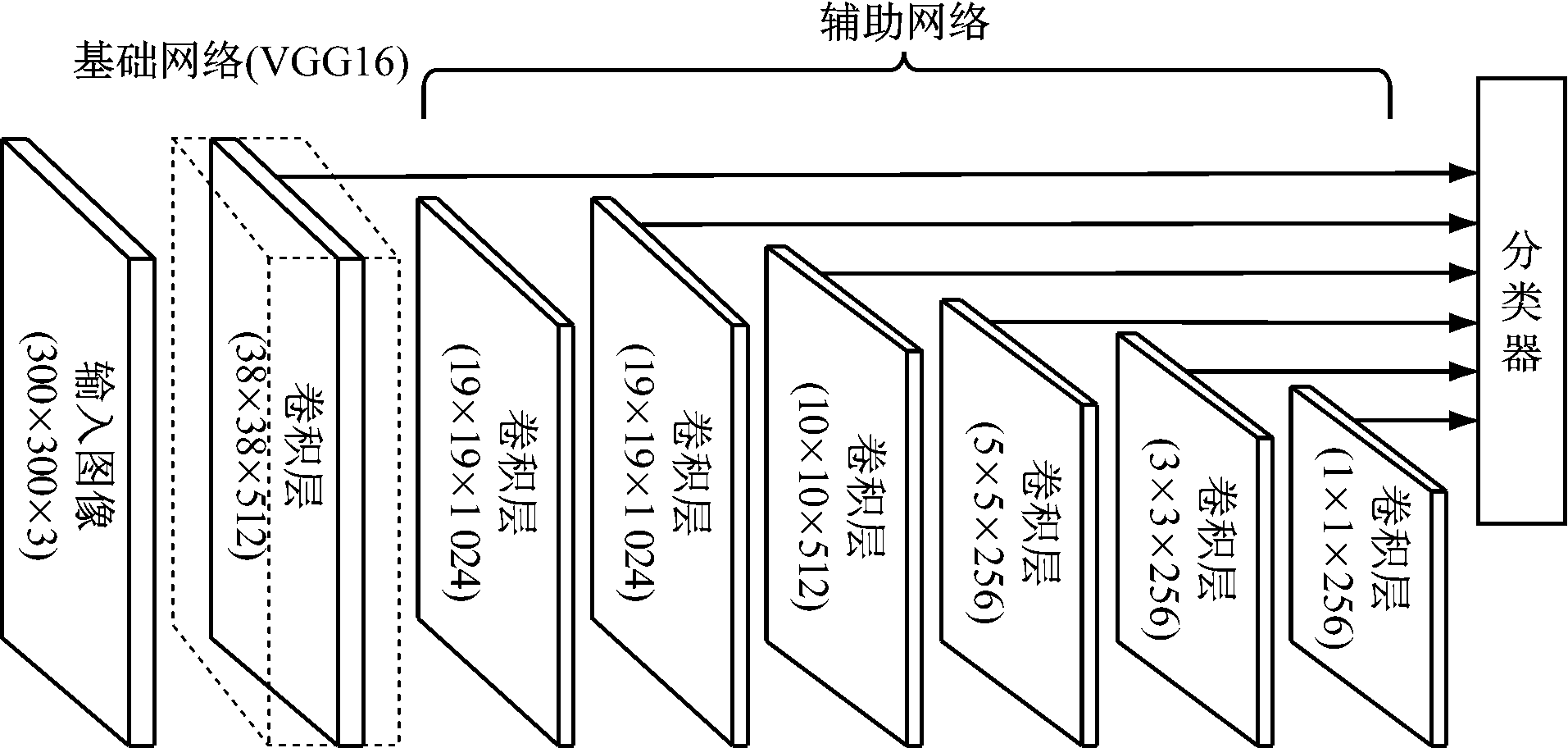

SSD网络主要由基础网络和辅助网络组成,如图1所示[13]。基础网络由VGG16网络[17]的卷积部分组成,主要用于对输入图像进行特征提取。辅助网络由基础网络上附加的卷积层组成,在尺度上逐步减小,可以进行多尺度预测。针对基础网络附加的每个卷积层,通过1组卷积核产生1组固定数量的预测集。对于一个m×n×p(m,n为尺寸,p为通道数)的特征层,利用一个3×3×p的卷积核对其进行预测,在特征层的mn个位置处产生一系列预测信息,包含类别信息和位置信息。

图1 SSD网络结构

Fig.1 SSD network structure

SSD网络在特征层的每个位置处预测k个边界框,同时预测每个类别出现在该位置的得分和预测位置相对于边界框的偏移量,从而在每个特征层的每个位置处分别预测ck(c为类别数)个得分和4k个位置偏移量。对于尺寸为m×n的特征层,共预测产生(c+4)kmn个输出量。通过非极大值抑制产生最终的预测边界框,并得到分类结果及位置信息。

2 改进SSD网络

SSD网络采用VGG网络作为基础网络,但VGG网络参数多,计算过程复杂,不适合在内存资源和计算能力有限的嵌入式平台上运行,也不符合井下视频行人实时检测的实际需求。本文在DenseNet网络基础上,设计了一种轻量级卷积神经网络作为SSD网络的基础网络,同时针对井下环境干扰大、采集图像质量差的特点,设计了一种基于ResNet网络的辅助网络,极大增强了特征表征能力,提高了井下视频行人检测的准确性。

2.1 改进的基础网络

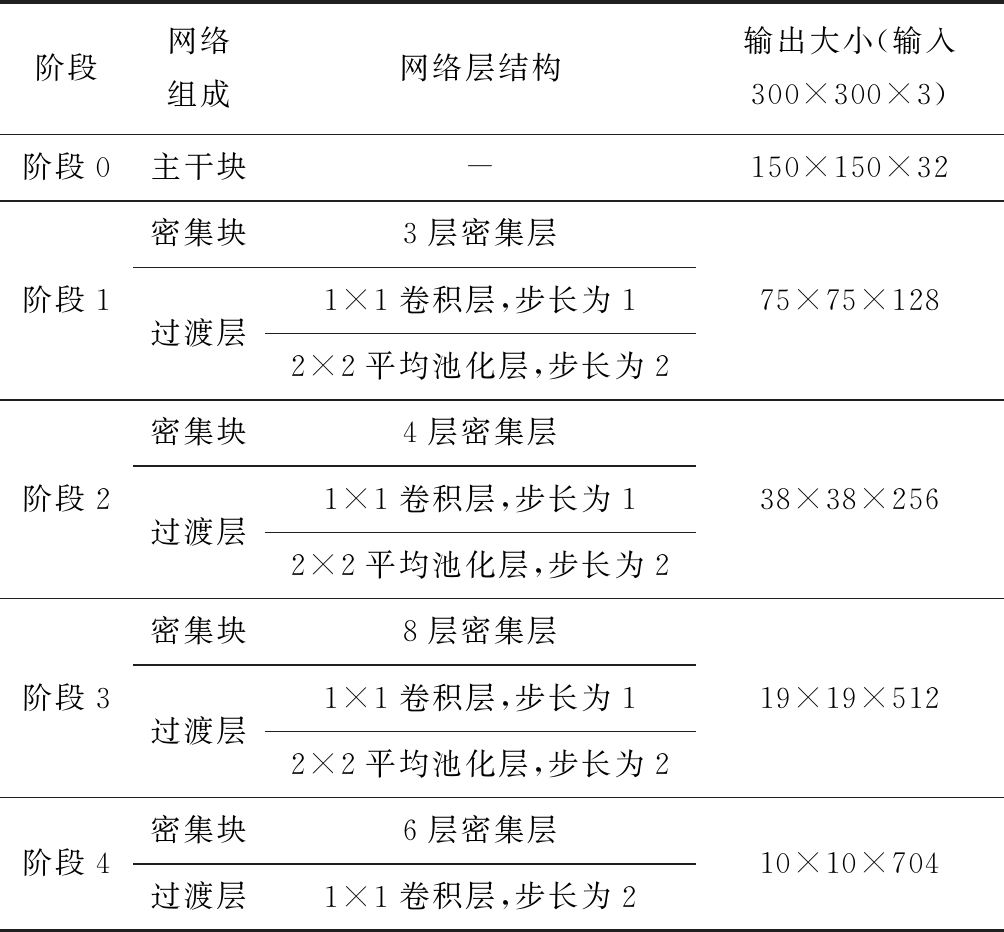

改进SSD网络的基础网络由1个主干块、4个密集块和4个过渡层组成,其结构参数见表1。该网络通过特征复用和旁路设置,大幅减少了网络参数,同时在一定程度上缓解了梯度消失问题,加快了网络收敛速度,提高了特征利用效率。

在文献[18]研究基础上,将原始DenseNet网络的第1个7×7卷积层替换为3个级联的3×3卷积层,在保证相同感受野的情况下加深了网络深度,减少了网络参数。在网络输入阶段,引入文献[19]提出的主干块结构并进行改进,以减少输入图像信息丢失并充分利用输入图像的原始信息。主干块结构如图2所示。

表1 基础网络部分结构参数

Table 1 Part structural parameters of basic network

图2 主干块结构

Fig.2 Stem block structure

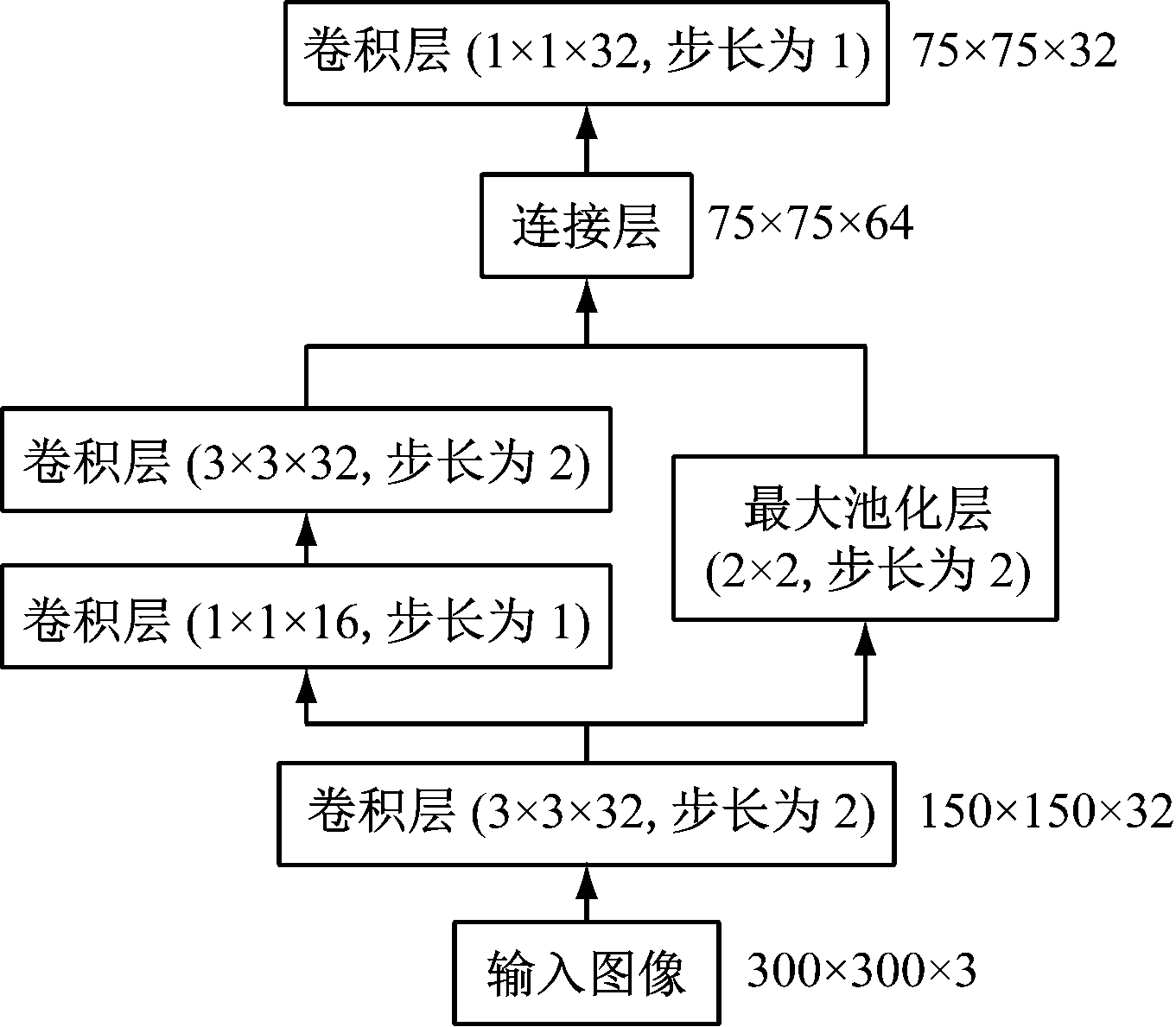

根据文献[18,20]研究结果,采用双路密集块结构,分别用不同大小的卷积核同时获取来自不同大小感受野的信息,同时将同一密集块中前后2个卷积层直接相连,以获得不同尺度的特征图及隐性深度监督的特性。双路密集块结构如图3所示。

图3 双路密集块结构

Fig.3 Double-way dense block structure

按照DenseNet网络连接模式设计基础网络的其他部分,同时在基础网络各卷积层中采用更窄的结构,即合理减少每个卷积层中卷积核数量,使参与训练的权重参数进一步减少,降低了网络复杂度,提高了网络收敛性能,使得改进SSD网络满足内存和计算能力的严格要求。

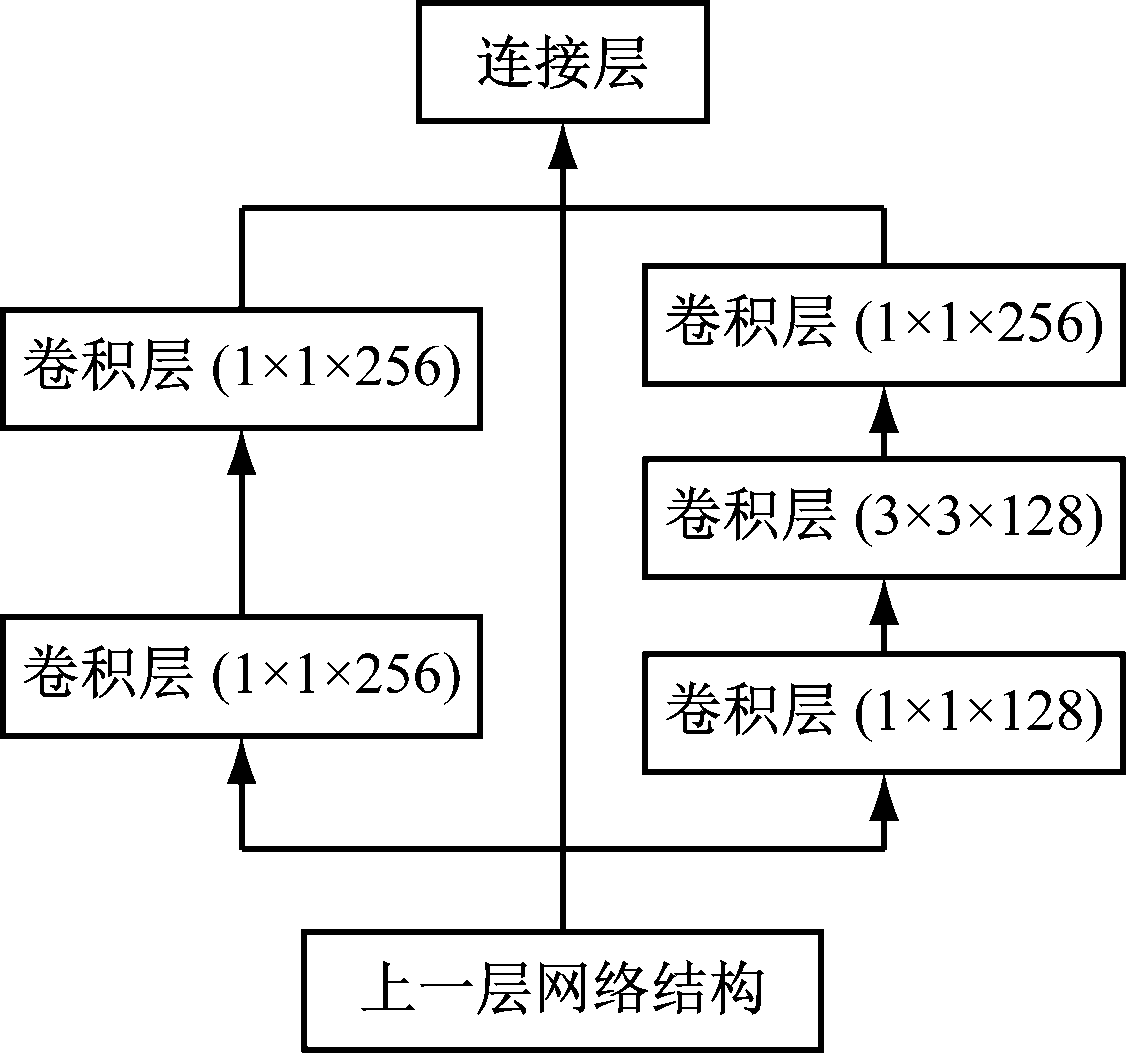

2.2 改进的辅助网络

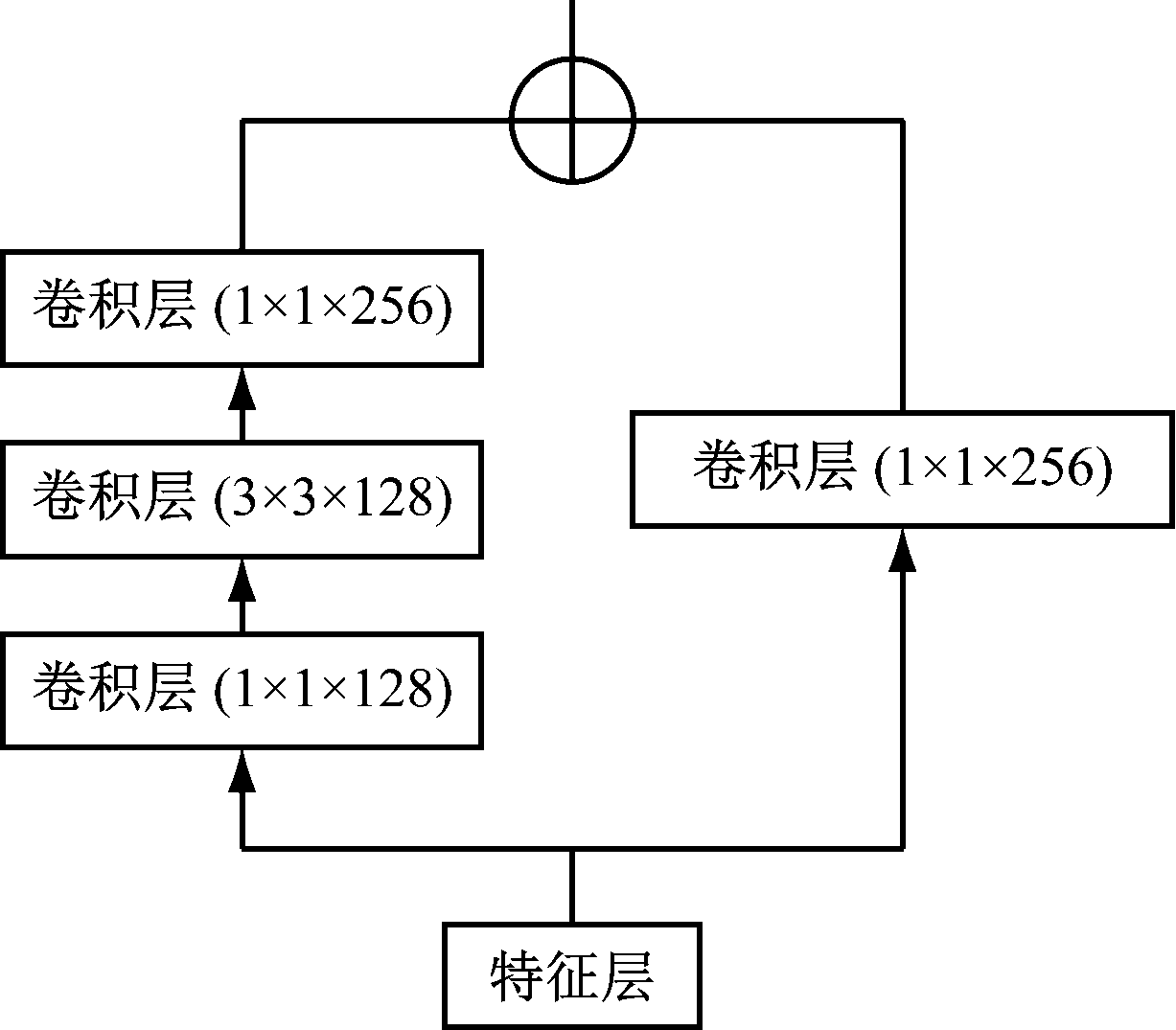

文献[21]提出目标检测网络在分类和回归阶段采用残差网络结构可提取更深维度的特征,提高特征利用效率,有效提升网络的准确性。本文基于ResNet网络,在SSD网络的辅助网络中引入残差模块,即对于每个特征层在进行预测前构建一个残差模块,如图4所示。

图4 残差模块结构

Fig.4 Residual block structure

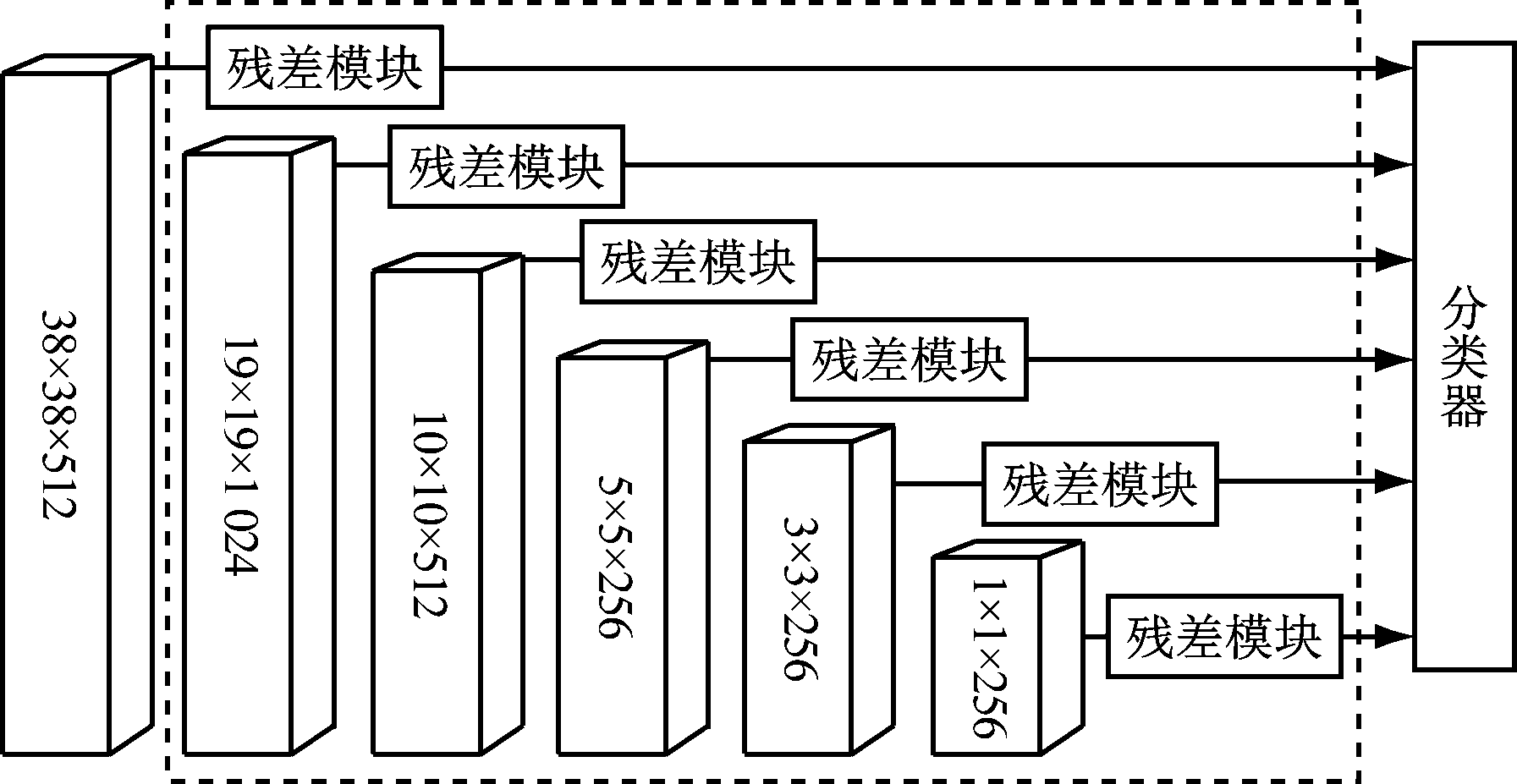

引入残差模块后SSD网络对特征层的变化更加敏感,能够在加深网络深度的同时,保证有效提取特征,因此能够使用1×1卷积核预测类别得分和位置偏移量,以更少的网络参数和更低的计算成本获得与使用3×3卷积核的网络基本相同的预测精度。改进的辅助网络结构如图5中虚线框内所示。

图5 改进的辅助网络结构

Fig.5 Improved auxiliary network structure

2.3 目标损失函数

网络目标损失函数是定位损失函数和置信度损失函数的加权和。定位损失函数和置信度损失函数在训练过程中对网络结构的准确度进行判定,并更新网络参数。目标损失函数为

(1)

式中:x为预测边界框与真实边界框的匹配度:c为标注类别;l为预测边界框坐标;g为真实边界框坐标;n为匹配的默认边界框数量,n=0时将损失设为0;Lconf(x,c)为置信度损失函数;Lloc(x,l,g)为定位损失函数;α为置信度损失函数和定位损失函数的权重。

定位损失函数为

(2)

式中:P为样本中的正例;m为边界框坐标或大小;(X,Y)为边界框左上角顶点坐标;w,h分别为边界框宽度和高度;![]() 为第i个预测边界框与第j个真实边界框关于第p个类别的匹配度,若匹配则为1,否则为0;smoothL1(·)表示定位损失函数采用smooth L1损

为第i个预测边界框与第j个真实边界框关于第p个类别的匹配度,若匹配则为1,否则为0;smoothL1(·)表示定位损失函数采用smooth L1损![]() 为第i个预测边界框;

为第i个预测边界框;![]() 为第j个真实边界框。

为第j个真实边界框。

置信度损失函数为

(3)

式中:![]() 为第i个预测边界框中的目标为第p个类别的概率;N为样本中的负例;

为第i个预测边界框中的目标为第p个类别的概率;N为样本中的负例;![]() 为第i个预测边界框中没有物体的概率,其值越大,则预测为背景的概率越高。

为第i个预测边界框中没有物体的概率,其值越大,则预测为背景的概率越高。

3 实验及结果分析

分别采用SSD网络和改进SSD网络进行井下行人检测实验,验证2种网络的检测性能。网络训练平台:CPU为Intel(R) Xeon(R) CPU E5-2678 v3;内存为64 GB DDR4;GPU为Nvidia Geforce GTX1080Ti;操作系统为64位Ubuntu16.04 LTS;实验框架为Caffe开源框架。网络测试平台为低功耗嵌入式平台Jetson TX2。

网络训练分为预训练和微调2个阶段。预训练阶段采用ImageNet数据集的数据初始化网络。微调阶段需要从大量样本中学习行人特征。若样本集不具备代表性,则很难选择出好的特征。因此首先将VOC数据集中的行人图像和井下行人检测数据集(来自某煤矿井下监控视频,按照VOC2007数据集标准制作,采用LabelImg软件标注,每张图像中行人为1~20人,且包含各种尺度)中的行人图像混合,作为第一轮训练集,进行4万次训练迭代,粗调网络,使网络充分学习行人所具备的特征。然后仅采用井下行人检测数据集训练网络,进行2万次训练迭代,精调网络,使网络充分适应井下环境中行人特征,并利用井下行人检测的测试集测试网络。整个训练过程中采用SGD(Stochastic Gradient Descent,随机梯度下降)反向传播优化网络。学习率为0.005,动量为0.9,权重衰减参数为0.000 5,每2万次迭代衰减1次学习率,衰减因子为0.1,共进行6万次迭代。

在Jetson TX2平台运行2种网络对井下视频中行人进行检测,结果表明,因井下图像质量较差,大小为95 MB 的SSD网络检测准确率为89.5%,23.7 MB的改进SSD网络检测准确率为87.9%,与SSD网络相差不大,但改进SSD网络运算速度达48帧/s,约为SSD网络的4.4倍,满足井下视频行人实时检测需求。

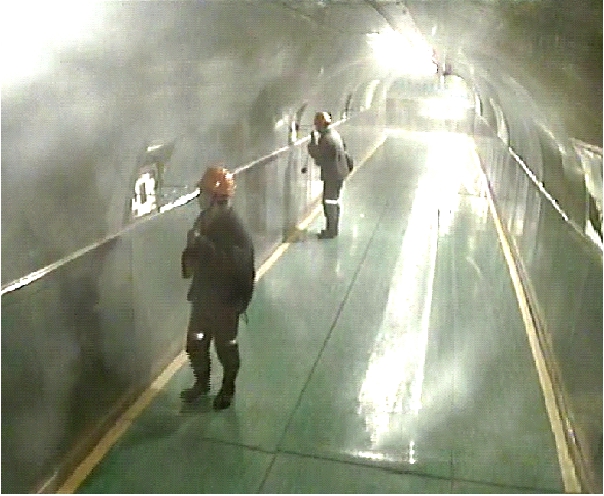

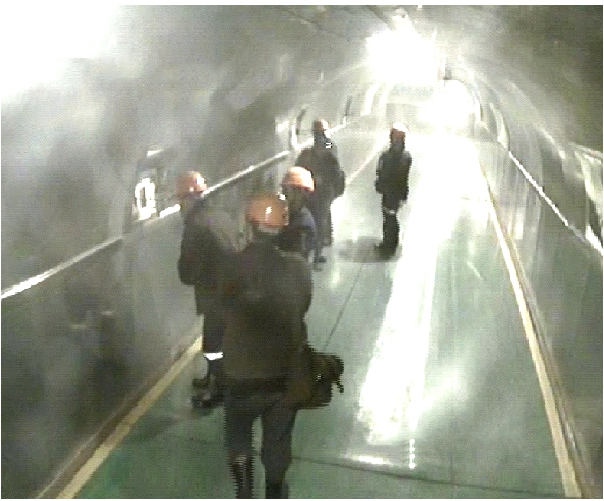

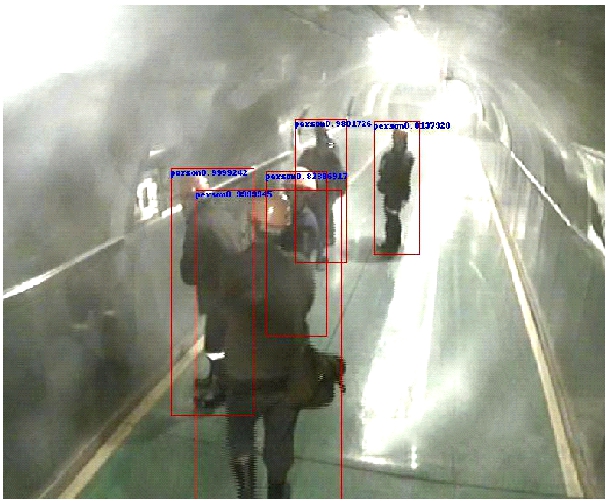

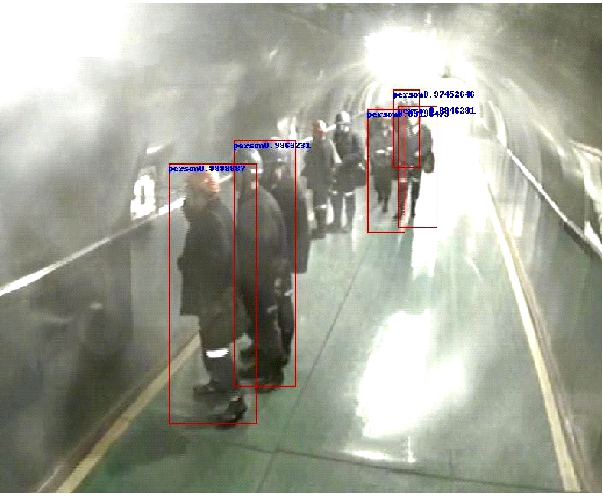

针对井下行人检测数据集的部分检测结果如图6所示。可看出针对井下行人低密度场景,改进SSD网络可有效定位并检测出行人,准确率近100%,检测效果与SSD网络一致;但当井下行人密集且出现严重遮挡时,改进SSD网络因采用轻量级卷积神经网络,特征提取能力有限,存在部分行人漏检现象。

(a) 原始图像

(b) SSD网络检测结果

(c) 改进SSD网络检测结果

图6 井下行人检测结果

Fig.6 Underground pedestrian detection results

4 结语

分别基于DenseNet网络和ResNet网络改进SSD网络的基础网络和辅助网络,并提出了一种基于改进SSD网络的井下视频行人检测方法。将改进SSD网络在低功耗嵌入式平台Jetson TX2上部署应用,结果表明其针对井下行人检测数据集的检测准确率为87.9%,与SSD网络基本相同,但运算速度达48帧/s,约为SSD网络的4.4倍,满足井下视频行人实时检测需求。该方法部署在低功耗嵌入式平台,可用于井下特定场所(如带式输送机机头和机尾等)的人员入侵检测,可现场实时报警,无需将视频图像传输到远端服务器,也可用于巡检机器人进行沿线行人检测。但该方法对于密集或遮挡严重的行人检测效果有待提高。下一步将重点研究井下遮挡或密集行人的检测及进一步提高实时性的问题。

参考文献(References):

[1] 孙继平,钱晓红.2004—2015年全国煤矿事故分析[J].工矿自动化,2016,42(11):1-5.

SUN Jiping,QIAN Xiaohong.Analysis of coal mine accidents in China during 2004-2015[J].Industry and Mine Automation,2016,42(11):1-5.

[2] 孙继平.煤矿事故分析与煤矿大数据和物联网[J].工矿自动化,2015,41(3):1-5.

SUN Jiping.Accident analysis and big data and Internet of things in coal mine[J].Industry and Mine Automation,2015,41(3):1-5.

[3] 田将杉.煤矿视频监控系统的应用现状与发展趋势[J].机械管理开发,2017,32(9):130-131.

TIAN Jiangshan.Status and development trend of video monitoring system in coal mine machinery[J].Mechanical Management and Development,2017,32(9):130-131.

[4] 杨超宇,李策,苏剑臣,等.基于视频的煤矿安全监控行为识别系统研究[J].煤炭工程,2016,48(4):111-113.

YANG Chaoyu,LI Ce,SU Jianchen,et al.Research on video-based system of activity recognition for coal mine safety surveillance[J].Coal Engineering,2016,48(4):111-113.

[5] DALAL N,TRIGGS B.Histograms of oriented gradients for human detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,San Diego,2005:886-893.

[6] MITA T,KANEKO T,HORI O.Joint Haar-like features for face detection[C]//Proceedings of the IEEE International Conference on Computer Vision,Beijing,2005:1619-1626.

[7] AHONEN T,HADID A,PIETIK INEN M.Face recognition with local binary patterns[C]//European Conference on Computer Vision,Berlin,2004:469-481.

INEN M.Face recognition with local binary patterns[C]//European Conference on Computer Vision,Berlin,2004:469-481.

[8] DOLL R P,TU Z,PERONA P,et al.Integral channel features[C]//British Machine Vision Conference,London,2009:1-11.

R P,TU Z,PERONA P,et al.Integral channel features[C]//British Machine Vision Conference,London,2009:1-11.

[9] TIAN Yonglong,LUO Ping,WANG Xiaogang,et al.Pedestrian detection aided by deep learning semantic tasks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,Boston,2015:5079-5087.

[10] OUYANG Wanli,WANG Xiaogang.Joint deep learning for pedestrian detection[C]//Proceedings of the IEEE International Conference on Computer Vision,Sydney,2013:2056-2063.

[11] SERMANET P,KAVUKCUOGLU K,CHINTALA S,et al.Pedestrian detection with unsupervised multi-stage feature learning[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,Washington,2013:3626-3633.

[12] LUO Ping,TIAN Yonglong,WANG Xiaogang,et al.Switchable deep network for pedestrian detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,Los Alamitos,2014:899-906.

[13] LIU Wei,ANGUELOV D,ERHAN D,et al.SSD:single shot multibox detector[C]//European Conference on Computer Vision,Amsterdam,2016:21-27.

[14] HE Kaiming,ZHANG Xiangyu,REN Shaoqing,et al.Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,Las Vegas, 2016:770-778.

[15] REN Shaoqing,HE Kaiming,GIRSHICK R,et al.Faster R-CNN:towards real-time object detection with region proposal networks[C]//Advances in Neural Information Processing Systems,Montreal,2015:91-99.

[16] REDMON J,DIVVALA S,GIRSHICK R,et al.You only look once:unified, real-time object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,Las Vegas,2016:779-788.

[17] SIMONYAN K,ZISSERMAN A.Very deep convolutional networks for large-scale image recognition[Z/OL].arXiv Preprint, arXiv:1409.1556.[2019-05-10]. https://arxiv.org/abs/1409.1556.

[18] HUANG Gao,LIU Zhuang,VAN DER MAATEN L,et al.Densely connected convolutional networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,Hawaii,2017:4700-4708.

[19] SHEN Zhiqiang,LIU Zhuang,LI Jianguo,et al.DSOD:learning deeply supervised object detectors from scratch[C]//Proceedings of the IEEE International Conference on Computer Vision,New York,2017:1937-1945.

[20] SZEGEDY C,VANHOUCKE V,IOFFE S,et al.Rethinking the inception architecture for computer vision[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,Las Vegas,2016:2818-2826.

[21] FU Chengyang,LIU Wei,RANGA A,et al.DSSD:deconvolutional single shot detector[Z/OL].arXiv Preprint, arXiv:1701.06659.[2019-05-21]. https://arxiv.org/abs/1701.06659.

[22] GIRSHICK R.Fast R-CNN[C]//Proceedings of the IEEE International Conference on Computer Vision,Santiago,2015:1440-1448.