巩固1,2, 朱华1

(1.中国矿业大学 机电工程学院 救援技术与装备研究所, 江苏 徐州 221116;2.江苏师范大学 计算机科学与技术学院, 江苏 徐州 221116)

摘要:针对标准尺度不变特征变换(SIFT)算法存在搜索视觉图像中关键点出现计算冗余和目标识别实时性差的问题,提出了一种改进的SIFT算法,并将其应用到煤矿救援机器人的环境信息感知和目标识别匹配中。该方法以马氏距离代替标准SIFT算法中的欧氏距离,简化了特征点提取,避免了特征点的误匹配。现场试验结果表明,改进后的SIFT算法提高了煤矿救援机器人对煤矿井下环境目标识别的实时性和目标匹配的准确性,为煤矿救援自主移动机器人实现避障、行走做好了视觉前提。

关键词:煤矿救援机器人; 自主移动; 目标识别; 特征点匹配; 尺度不变特征变换算法; 马氏距离

煤矿井下救援机器人主要用于煤矿井下发生安全事故时代替救援人员实现实时探测和紧急救援任务,并向地面救援人员实时传回灾后环境信息,给地面救援人员实施救援方案提供科学依据,最大限度地减少人员伤亡、财产损失和避免再次发生灾难。现在国内外对智能型机器人的研究已经成为热点,自主救援机器人的视觉信息研究成为其中的研究重点。救援机器人视觉信息主要用于视觉定位、目标跟踪、视觉避障等[1-3]。视觉识别(图像识别)就是图像再认,是救援机器人视觉感官通过存储的视觉信息与当前的视觉信息进行比较的加工过程,是通过电子化感知和理解视频图像[1]。在煤矿发生灾害时,要实现救援机器人传回灾后环境情况,对其视觉系统要求较高,获取的视频图像要能反映机器人对环境信息的实时感知和目标识别匹配等。

现在多采用基于颜色信息和基于纹理信息的方法对图像进行分割处理,以实现对环境目标识别和机器人避障。基于颜色信息的目标辨别普遍采用HSI(Hue-Saturation-Intensity)颜色模型,采用这种颜色模型进行目标辨别时对自然场景的光照变化较为敏感[2-3],多应用在地面光照条件比较好的环境中。因煤矿井下光照度比地面差,故煤矿救援机器人视觉识别需要探寻一种新的目标识别算法,该识别算法要能实现机器人视觉在确保环境目标识别率较高的同时,受光照影响较小。为此,SIFT(Scale-invariant Feature Transform,尺度不变特征变换)算法[4]被提出来,SIFT算法在图像尺度缩放、旋转、光照和视角等条件变化的情况下,对环境目标识别时具有较好的鲁棒性。SIFT算法被提出后,很多研究者对其进行了改进和应用研究,取得了非常好的效果,如文献[5]应用SIFT算法与卡尔曼滤波结合实现了机器人对环境的三维重建和定位;文献[6]将SIFT算法用于机器人足球比赛中的目标识别,获得了良好的效果;文献[7]研究了视觉导航方法,将SIFT算法应用到机器人视觉导航中,取得了很好的实验结果;文献[8]提出了机器人在动态环境中利用SIFT算法实现对特定人员的身份视觉识别;文献[9]利用SIFT算法改进机器人自适应压缩跟踪对象;文献[10]提出了基于图像兴趣点思想获取图像目标特征点的算法改进;文献[11]利用SIFT算法思想实现在三维图像中寻找特征点;文献[12]在SIFT算法的基础上提出了很好的原始图像和目标图像直接的特征识别思想;文献[13]提出将待匹配的图像进行归一化处理后,利用筛选感兴趣的特征点进行匹配,减少了匹配的特征点和SIFT算法的运行时间,提高了SIFT算法运行效率。本文基于上述文献,特别结合文献[3]和文献[14]思想提出了一种改进的SIFT算法,并将其应用到煤矿救援机器人的环境信息感知和目标识别匹配中。改进的SIFT算法简化了特征点提取,用马氏距离替代标准SIFT算法中的欧氏距离,提高了煤矿救援机器人对环境目标识别的实时性和目标匹配的准确性。

标准SIFT算法对目标辨别提取的特征是一种点特征,采用对连续3幅高斯差分图像边缘附近的极值点进行特征提取。SIFT算法主要包括下面4个步骤[4]。

(1) 建立尺度空间进行极值检测:尺度空间采用图像与高斯核函数[3]卷积实现。对于1幅二维图像,其二维尺度可变高斯函数定义如下:

G(x,y,σ)=![]() exp[-(x2+y2)/2σ2]

exp[-(x2+y2)/2σ2]

(1)

式中:(x,y)为变换后的图像坐标;σ为尺度空间因子,它也是高斯正态分布的方差。

1幅二维图像的尺度空间定义可采用式(2)卷积表达。

L(x,y,σ)=G(x,y,σ)S(x,y)

(2)

式中S(x,y)表示算法输入的二维图像。

为了寻找图像尺度空间的局部极值点,SIFT算法要将图像中的每一个检测像素点和其所有的相邻点进行比较,以获取极值点。将检测点与它的8个相邻点和上下相邻尺度对应的18个点,总共26个点进行比较,如果该检测点是这些点中的极值点(极大值或极小值),就将该点作为一个局部极值点,即该点就成为图像在尺度下的一个特征点,记下该点的位置和对应尺度,并将所有这样的局部极值点作为算法的候选关键点。

(2) 精确关键点(极值点)位置:为了确保精确关键点的位置和尺度,必须去除对比度低的关键点和不稳定的边缘响应点[3-6],目的是提高图像特征点匹配稳定性,增强算法的抗噪声能力。将式(1)进行泰勒展开,求其导数展开式,然后将展开式的值设为0,可以得出精确的极值位置![]() 式(3))。将式(3)代入式(1)的泰勒展开式,可以去除低对比度特征点,即计算出

式(3))。将式(3)代入式(1)的泰勒展开式,可以去除低对比度特征点,即计算出![]() 式(4))。

式(4))。

(3)

(4)

(3) 关键点方向匹配:通过尺度不变性获取极值点(关键点),可以使其具有缩放不变的性质。为了确保算子对图像具备旋转不变性,利用关键点领域像素的梯度方向分布特性,需要给每个关键点(极值点)指定一个或多个方向参数[4,10]。对于极值点的采样点F(x,y)分别计算梯度值m(x,y)和方向θ(x,y)。

m(x,y)=[F(x+1,y)-F(x-1,y)]2+ [F(x,y+1)-F(x,y-1)]2

(5)

θ(x,y)=arctan![]()

(6)

在获取每个采样点的梯度大小和方向后,需要确定每一个关键点梯度的大小与方向。对每一个关键点统计邻近一个窗口内所有采样点的梯度大小和方向,绘制出梯度直方图。梯度直方图采用每10°为一柱,总共36柱,故梯度直方图范围为0~360°,直方图峰值所在的方向代表关键点处邻域梯度的主方向,也就是该关键点的主方向。

(4) 关键描述子的生成:为了确保图像旋转不变性,首先将坐标轴旋转设为关键点的方向,对任一关键点,在其中心取16×16的窗口,将这个窗口均匀分为16个4×4的子窗口。对每个4×4的子窗口计算8个方向的梯度直方图,则每个关键点可用16个种子点来描述。对16个子窗口的8个方向的梯度直方图根据位置依次排序,可以构成1个4×4×8共128维的SIFT特征向量。SIFT特征向量已经去除了尺度变化、旋转等几何影响因素。对这些SIFT特征向量的长度进行归一化,可进一步去除光照变化的影响。得到的128维的特征向量就是SIFT特征点描述子[5,10]。

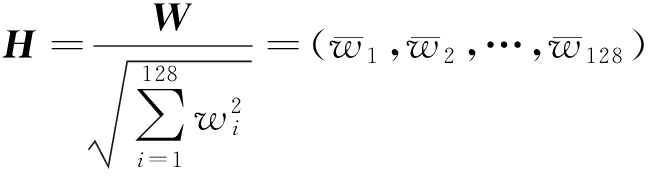

为了确保128维的特征点对光照强度变化不敏感,需进行归一化计算处理,得到规划后的向量H=(h1,h2,…,h12),在归一化处理过程中,采用式(7)计算H,其中W是特征点描述子,W=(w1,w2,…,w12),代表特征向量值。

(7)

标准SIFT算法将整个尺度空间中搜索到的极值点全部作为关键点,产生了冗余,增加了很多无效的计算量。改进的SIFT算法不计算整个空间尺度的关键点,提出了一种定位关键点思想,利用几何不变矩提取图像空间的边缘,主要对图像边缘的尺度空间计算搜索极值点,边缘关键点确认后,再使用SIFT算法。

2.1 特征点简化

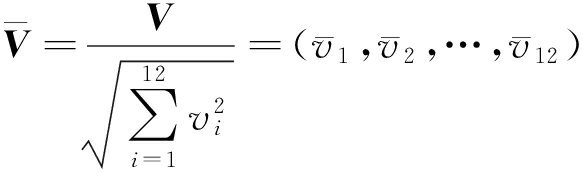

在标准SIFT算法的第3步中,为确定关键点(极值点),必须指定一个主方向,图像旋转之后,极值点(关键点)周围的子区域均会发生变化。二维坐标具有矩形特征,矩形不具有旋转不变性,若采用圆形坐标系,可以减少关键点的一些参数计算。本文采用圆形坐标特点构造图形尺度空间的特征描述符,以特征点为圆的中心。采用圆形窗口区域时要确保图像关键点的邻域没有变小,同时不破坏原有算法的邻域方向性信息。要实现同心圆坐标,须将SIFT算法中关键点16×16邻域的圆形窗口区域作为计算所有采样点的梯度,然后提取4个同心圆环子区域,它们的半径从外到内分别为8、6、4和2像素。在4个圆环区域内分别按360°均匀划分12个方向上的梯度直方图,计算同心圆环中12个方向的梯度累加值,得到每个同心圆的一个12维的种子点,用特征向量V=(v1,v2,…,v12)表示。为减少煤矿井下光照变化影响,将梯度方向归一化计算代入式(7),得到式(8)。

(8)

改进的SIFT算法为确保图像尺度空间任意旋转不变性,即任意旋转时排序值不发生变化,要对每个同心圆的梯度累加值进行从大到小排序。假如最内同心圆的12维统计量中v6为最大值,即v6=max{vi,vi∈V,i=1,2,…,12},则向左循环移动V中向量序列,最后特征向量为V=(v6,v7,…,v12,v1,v2,…,v5)。每个同心圆的特征向量排好后,将每个圆环的12个梯度累加值按照从内到外的顺序排好,即第1个同心圆的梯度累加值排为v1,v2,…,v12,第2个接着排为v13,v14,…,v24,依次类推,4个同心圆共有48个元素,最后就实现了图像尺度空间简化的特征点的特征描述符,从而实现了空间尺度旋转不变性。

2.2 2次特征点匹配

对于特征点的匹配,标准SIFT算法采用欧氏距离,欧氏距离在图像特征点匹配方面有明显的缺点,即欧氏距离将样品的不同属性(即各指标或各变量)之间的差别采用等同处理方式,这一点在图像特征点匹配时不能满足实际要求。马氏距离不受计算量纲的影响,两点之间的距离计算与原始数据的测量单位不相关。马氏距离有3个重要的性质[3,9,14]:平移不变性、旋转不变性和放射不变性。本文在目标视频图像初次特征点匹配后,采用马氏距离进行第2次匹配。采用马氏距离处理数据时,不再把被处理的数据看作是冷冰的单纯数字,由于马氏距离引入了协方差,承认了客观上被处理的数据间的差异性,使数字之间具有了相应的属性与关系,所以,在视频图像识别中其模式识别性能优于欧氏距离[3,14]。

对于一个样本均值为μ=(μ1,μ2,…,μn)、协方差矩阵为Σ的多变量向量x=(x1,x2,…,xn),马氏距离表达式为

DM(x)=![]()

(9)

马氏距离也可以定义为服从同一分布、协方差矩阵为Σ的随机变量x和y的差异程度,其计算见式(10)。从式(10)可以看出,目标匹配时存在差异性。利用马氏距离筛选视频图像的特征点可以避免一些点被误匹配[3,15],提高图像特征点匹配精度。将图像上选取出的特征点作为匹配的一系列测试点,这些测试点具有x与y两个特征向量,将匹配图像的特征点作为总体,利用马氏距离计算每一个测试点到总体的距离。在2幅视频匹配图像上,对应的测试点到总体的马氏距离是相同的。

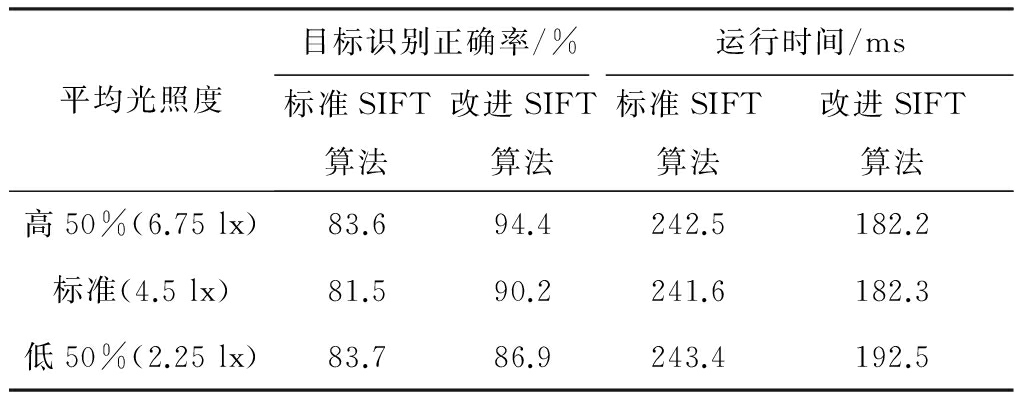

DM(x,y)=![]()

(10)

要在恶劣危险的煤矿井下代替人完成复杂自主活动,煤矿救援机器人首先通过视频传感器获取井下环境图像,根据视频图像得出对井下环境的机器理解,然后根据视觉进行环境识别以实现运动控制。煤矿救援机器人在运动中,要实现避障、物体识别等。煤矿救援机器人对环境物体的自动识别是实现其自主移动与避障的关键技术,通过分析视频图像信息实现目标匹配和环境感知。为了验证改进的SIFT算法的可靠性,在山东某煤矿井下进行了机器视觉试验,利用改进的SIFT算法实现煤矿井下救援机器人的环境目标匹配和环境分析与感知。试验环境光照度参照文献[15],在相同试验运行软件与硬件条件下,标准SIFT算法与改进的SIFT算法的性能对比结果见表1。由表1可知,改进的SIFT算法具有更好的实时性和稳定性,表1中的正确率和运行时间均是多次试验的平均值。

表1 2种算法的性能对比结果

Table 1 Comparison results of performance of two algorithms

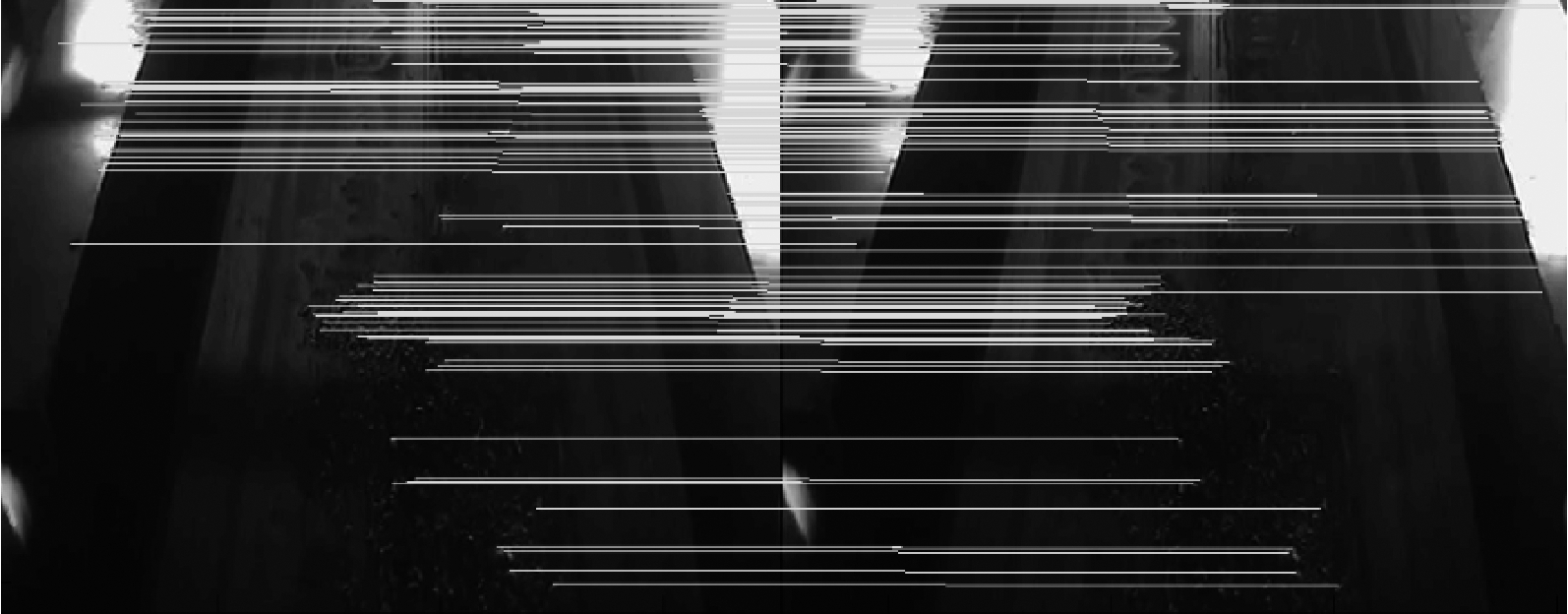

煤矿井下环境光线较暗,视觉传感器在光线暗的地方会出现视频图像质量下降的现象,但经过视频图像处理后,获取的信息能给机器人提供环境信息并用于物体识别,限于篇幅,随机采集了井下不同时刻的3幅图像,如图1所示。首先对视觉图像采用均衡化处理,对时刻1图像处理后的结果信息如图2所示,对时刻2图像和时刻3图像处理与对时刻1图像的处理方法一致。

(a) 时刻1

(b) 时刻2

(c) 时刻3

图1 视觉采集图像

Fig.1 Images of acquired visual

图2 视觉信息处理结果

Fig.2 Results of visual information processing

图3(a)是利用本文算法实现对图1中时刻1图像与时刻2图像的视觉空间匹配与识别结果,图3(b)是利用本文算法实现对图1(b),(c)的视觉空间匹配与识别结果。

由图3可以看出,机器人利用改进的算法很好地识别了不同的物体,同时减少了物体的匹配点,且算法可以实现实时运行。

(a) 不同时空环境识别匹配

(b) 不同时刻同一空间环境识别匹配

图3 视觉匹配

Fig.3 Visual matching

在煤矿井下光照条件极差的环境中,煤矿救援机器人的目标识别和匹配的难度强于地面,煤矿救援机器人需感知环境,实现避障、行走等。将改进的SIFT算法应用到煤矿救援机器人的目标识别与匹配中,实现了移动机器人对目标的识别和视觉图像的匹配,提高了煤矿救援机器人对煤矿井下环境目标识别的实时性和目标匹配的准确性,为煤矿救援自主移动机器人实现避障、行走做好了视觉前提。

参考文献(References):

[1] 马颂德,张正友.计算机视觉——计算理论与算法基础[M].北京:科学出版社,2003.

[2] SCHMID C, MOHR R. Local gray value invariants for image retrieval [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1997,19(5):530-535.

[3] 陈裕,刘庆元.基于SIFT算法和马氏距离的无人机遥感图像配准[J].测绘与空间地理信息,2009,32(6):50-53.

CHEN Yu, LIU Qingyuan. The unmanned aerial vehicles remote sensing image registration based on SIFT algorithm and Mahalanobis distanc[J].Geomatics & Spatial Information Technology,2009,32(6):50-53.

[4] LOWE D G. Distinctive image features from scale-invariant key-points[J].International Journal of Computer Vision,2004,60(2):91-110.

[5] ZHONG Q, ZHAO J. Research on 3D reconstruction for robot based on SIFT feature[C]// IEEE Advanced Research and Technology in Industry Applications, 2014:976-979.

[6] HU M, CHEN J, SHI C. Three-dimensional mapping based on SIFT and RANSAC for mobile robot[C]//IEEE International Conference on Cyber Technology in Automation, Control, and Intelligent Systems,2015:139-144.

[7] ZHU Q, LIU C, CAI C. A novel robot visual homing method based on SIFT features[J]. Sensors, 2015, 15(10):26063-26084.

[8] SATAKE J, CHIBA M, MIURA J. A SIFT-based person identification using a distance-dependent appearance model for a person following robot[C]//IEEE International Conference on Robotics and Biomimetics, 2012:962-967.

[9] YANG H, JIANG X, GAO S. Adaptive compressive tracking algorithm based on SIFT features[C]//Third International Conference on Robot, Vision and Signal Processing, 2015:78-81.

[10] NAVARRO F, ESCUDERO-VINOLO M, BESCOS J. SP-SIFT: enhancing SIFT discrimination via super-pixel-based foreground-background segregation[J]. Electronics Letters, 2014,50(4):272-274.

[11] JOGLEKAR J, GEDAM S S, MOHAN B K. Image matching using SIFT features and relaxation labeling technique—A constraint initializing method for dense stereo matching[J]. IEEE Transactions on Geoscience & Remote Sensing, 2014, 52(9):5643-5652.

[12] MITTAL A, MURALIDHAR G S, JOYDEEP G, et al. Blind image quality assessment without human training using latent quality factors[J]. IEEE Signal Processing Letters,2012,19(2):75-78.

[13] SHEN Xingxing, BAO Wenxing. The remote sensing image matching algorithm based on the normalized cross-correlation and SIFT[J]. Journal of the Indian Society of Remote Sensing,2014,42(2): 417-422.

[14] 黄飞,周军,卢晓东.基于马氏距离的一维距离像识别算法仿真[J].计算机仿真,2010,27(3):31-34.

HUANG Fei, ZHOU Jun, LU Xiaodong. The simulation of one-dimensional range profile recognition based on Mahalanobis distance[J]. Computer Simulation, 2010,27(3):31-34.

[15] 郭燕,施喜书,周瑜.煤矿井下照明的分析与研究[J].煤炭工程,2013,12(增刊2):128-129.

GUO Yan, SHI Xishu, ZHOU Yu. Analysis and research on underground lighting of coal mine[J]. Coal Engineering, 2013,12(S2):128-129.

Environmental target image recognition of coal mine rescue robot

GONG Gu1,2, ZHU Hua1

(1.Institute of Rescue Technology and Equipment, School of Mechatronic Engineering, China University of Mining and Technology, Xuzhou 221116, China; 2.School of Computer Science and Technology, Jiangsu Normal University, Xuzhou 221116, China)

Abstract:In view of problems that traditional scale-invariant feature transform(SIFT) algorithm has calculation redundancy in searching key points of vision images and poor real-time performance in target recognition, an improved SIFT algorithm was proposed which was applied to coal mine rescue robot to realize environmental information perception and target recognition matching. The improved SIFT algorithm adopts Mahalanobis distance to replace Euclidean distance in the traditional SIFT algorithm and simplifies extraction of the image feature points, avoids mismatching of feature point. The field test results show that the improved SIFT algorithm improves real-time performance in underground environmental target recognition and accuracy of target matching of coal mine rescue robot, which makes visual premise for realizing obstacle-avoidance and walking of coal mine rescue autonomous robot.

Key words:coal mine rescue robot; autonomous mobile; object recognition; feature point matching; scale-invariant feature transform algorithm; Mahalanobis distance

文章编号:1671-251X(2017)07-0007-05

DOI:10.13272/j.issn.1671-251x.2017.07.002

收稿日期:2017-01-09;

修回日期:2017-04-27;责任编辑:张强。

基金项目:国家高技术研究发展计划(863计划)项目(2012AA041504);国家自然科学基金项目(61402207)。

作者简介:巩固(1976-),男,安徽泗县人,讲师,博士研究生,长期从事人工智能、智能计算、机器人视觉等方面的研究和实践工作,E-mail: xzgonggu@163.com。

引用格式:巩固,朱华.煤矿救援机器人环境目标图像识别[J].工矿自动化,2017,43(7):7-11. GONG Gu,ZHU Hua.Environmental target image recognition of coal mine rescue robot[J].Industry and Mine Automation,2017,43(7):7-11.

中图分类号:TD77

文献标志码:A 网络出版时间:2017-06-27 15:53

网络出版地址:http://kns.cnki.net/kcms/detail/32.1627.TP.20170627.1553.002.html